人類とAIは共存できるのか?

AIガバナンスを巡る論点2025 ①

須藤 修

中央大学 教授

AI(人工知能)が驚くべきスピードで進化している。人間の知をはるかに超えるAGI(汎用人工知能)、ASI(人工超知能)の実現も近いという見方もある。AIは、人間にとって便利な道具であり続けるのか、はたまた、人間を支配する脅威となるのか――。今こそ、AIガバナンスについて論じる時である。デジタル政策フォーラムのメンバーおよび関係者にその問題意識を聞く。第1回は、須藤修 中央大学国際情報学部 教授による現状俯瞰と論点提起。

須藤修 中央大学国際情報学部 教授

須藤修 中央大学国際情報学部 教授論点1 今、何が起きているのか?

- 1-1 AIとは何か? 知能とは何か?

- 1-2 世界AIランキングで日本は9位

- 1-3 米国1位: R&D、経済効果、インフラで圧倒的先行

- 1-4 中国2位: R&D、インフラで米国を猛追

- 1-5 英国3位: 教育とAIガバナンスで存在感

- 1-6 日本は9位: インフラ健闘、AIガバナンスに一定評価も・・・

- 1-7 「AIの民主化・大衆化」というディープインパクト

- 1-8 基盤モデルがLLMからマルチモーダルに進化

- 1-9 エージェントAI本番、社会システムが変貌へ

- 1-10 熾烈なAI開発競争、日本の影薄く・・・

- 1-11 2024年、フランスが頭角現す

- 1-12 AIモデル数、GoogleとOpenAIが7機でトップ

- 1-13 人間の専門家レベルを超え始めた

- 1-14 Google、OpenAI、DeepSeekが性能3強

- 1-15 AGI(汎用人工知能)はいつできるか?

- 1-16 AGIは5年以内に、その次はASI(人工超知能)へ

1-1 AIとは何か? 知能とは何か?

AI(人工知能)とは、「人間のような知能や行動をコンピューターを使って人工的に作り出す技術」の総称である。既に幅広い分野で活用されている。例えば、工場の不良品検査、医療診断の支援、健康管理支援、自動運転、農産物の選別作業、工事用重機の無人運航、農作業ロボット、経理事務などである。

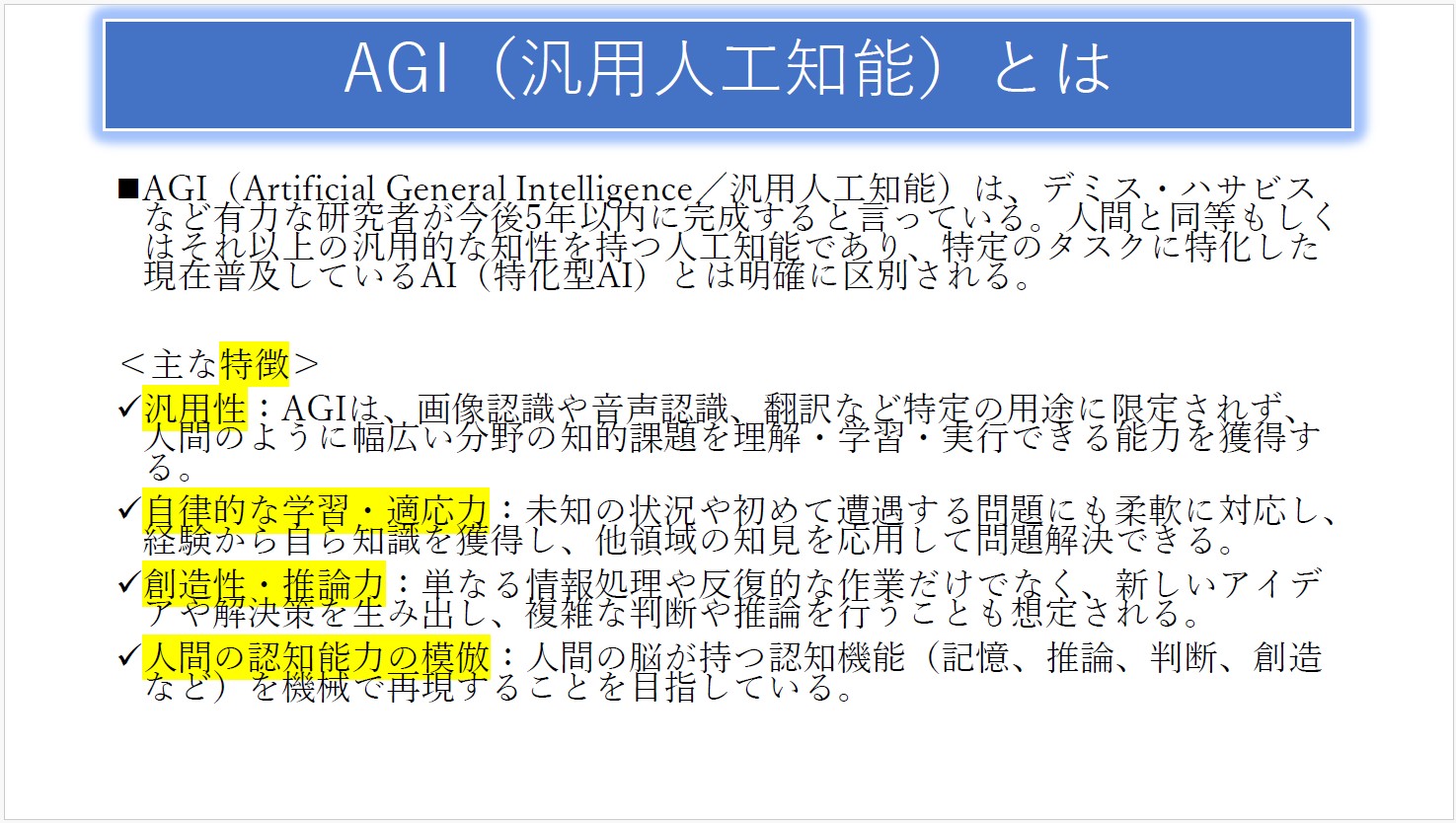

これまでは、ある特定の目的のためにつくられた「特化型AI」が一般的だったが、人間のように幅広いことを柔軟にこなせる「汎用型AI」の研究開発が進んでいる。AGI(Artificial General Intelligence、汎用人工知能)と呼ばれるものである。それをさらに進化させたASI(Artificial Superintelligence、人工超知能)も視野に入ってきている。

AIは、人間の知能に匹敵する、あるいは、それをはるかに超えるようなレベルに達しようとしている。こうなってくると、「AIとは何か?」の前に「知能とは何か?」という根源的な問いに答える必要がある。

デジタル空間の情報流通という観点では、インターネット上で流通するデータの質がリッチになり量が増大している。ほんの7~8年前に議論していたのは、一般的なエンドユーザーがスマートフォンで写真や動画を撮ってアップロードすることが容易になり、専門的・職業的なクリエイター以外が創るコンテンツが増大してインターネットに負荷をかけているので、そのコストを誰が負担するのか、ネットワークの中立性をどう確保するのか、だった。

生成AIの登場で、インターネットにはさらに負荷がかかる状況になっている。私も生成AIで画像やスライドを作っている。動画像を含めて膨大なデータが生成AIによって作成され、インターネットにどんどん流入し、やり取りされている。俯瞰してみれば、人間と人間のコミュニケーション以外の部分が非常に大きくなっている、言い換えれば、人間が知らないところでAIが大量のデータを作り出し、人間が知らないうちにネットワーク上でやり取りしている。これがネットワークの側で起きていることである。

少し前までは、ネットワークレベルで寡占的であることが世の中全体の支配につながるというイメージがあったが、生成AIがインターネットにつながった今、物理空間における支配力が改めてものを言うようになっている。生成AIを動かすには、膨大な数のGPUを確保してフル稼働させなければならないし、いくつものデータセンターを建設し、それを動かすための大電力も必要である。つまり、物理的な限界がデジタル空間における情報の生成・流通の限界を決め、物理的なものを支配する者がサイバー空間を支配する色合いが、再び濃くなっているのである。土地・建物などの物理空間や電力の供給を規律し、産業政策と連関させてきたのは国家である。それはすなわち、サイバー空間における国家の役割が再び顕在化し、重要性が増すことを意味する。

だとすれば、そしてAIが社会の隅々にまで影響を及ぼす時代が来るとすれば、政治のプロセス、選挙のプロセスもAI時代に合わせて変えていかなければならない。すべての政策を点検し、組み立て直し、提案し、それを実現できる政治あるいは政治共同体が勝ち、できない共同体は負けていくことになるだろう。

その際には、市民の参加を促し、市民を巻き込み、市民を取り残さないことが、重要である。市民の理解抜きにAI社会政策を推進することは危険であり、そんなことをすればいつか大きな反動・反発を生みかねない。インターネットがそうであったように、若い世代や先進的な企業の自由な利活用に制限をかけることなく、政治・行政・市民の協働によって変革を推進すべきである。そのプロセスにおいてもAIを最大限に活用すべきことは言うまでもありない。

1-2 世界AIランキングで日本は9位

AIの開発競争が世界的に激しさを増す中で、日本はどの辺りにいるのか――。

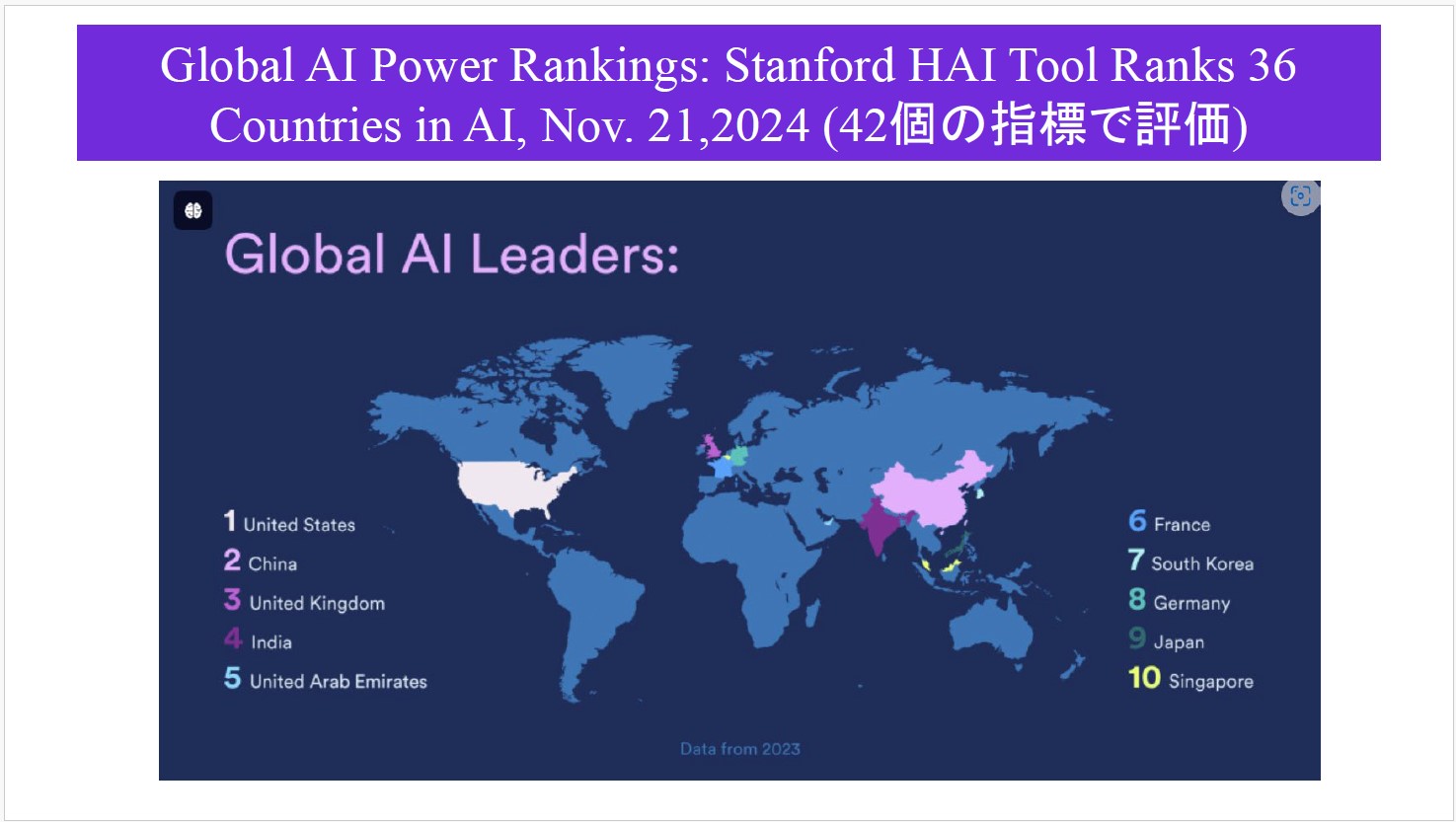

米スタンフォード大学の人間中心AI研究所(Human-Centered Artificial Intelligence, HAI)は2024年11月、42個の指標を使って36か国を比較分析したランキングを発表した(Global AI Power Rankings: Stanford HAI Tool Ranks 36 Countries in AI)。余談だが、この地図はAIで作ったものと推察されるが、日本列島の位置が大きくずれているのは現在のAIはまだ発展途上であることを示している。

このランキングでは、断然トップが米国、2位が中国、3位が英国、4位がインド、5位がアラブ首長国連邦(UAE)、6位がフランス、7位が韓国、8位がドイツ、9位が日本、10位がシンガポールという結果だった。

興味深いのは、フランス、ドイツなどのEU(欧州連合)陣営がインドやUAEの後塵を拝していること。規制の強さ・弱さが影響しているのではないか。もう一つは韓国の健闘である。韓国が提供しているAI向け学習用データベースの質が高く、世界の様々なAI開発者が活用している。OECD(経済協力開発機構)のAI関連会議などに出席すると、韓国に対する各国からのリスペクトのようなものを感じる。

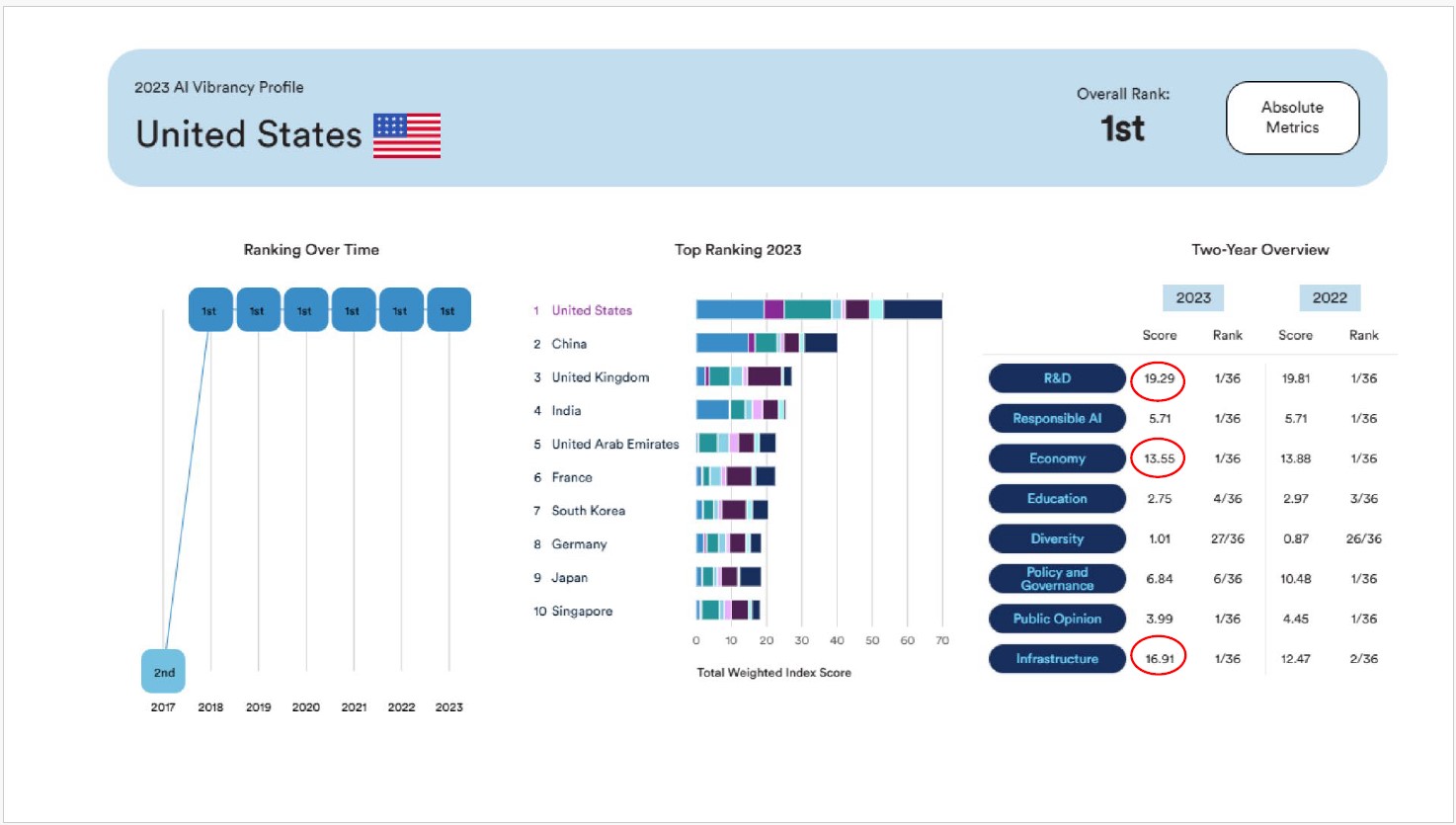

1-3 米国1位: R&D、経済効果、インフラで圧倒的先行

国別の分析では、1位の米国は「R&D」のポイントが非常に高く、「Economy(経済的波及効果)」も大きく、スーパーコンピューターやデータセンターといったAI開発・活用のための「Infrastructure」の整備が進んでいる。

「Responsible AI(責任あるAI)」は36カ国中1位。「Education」は米国に限ったことではないが今後の課題。「Diversity」にはあまり力が入っているとは言えない。「Policy & Governance」は低下傾向だけれども高水準。「Public Opinion」はまあまあ、といったところ。

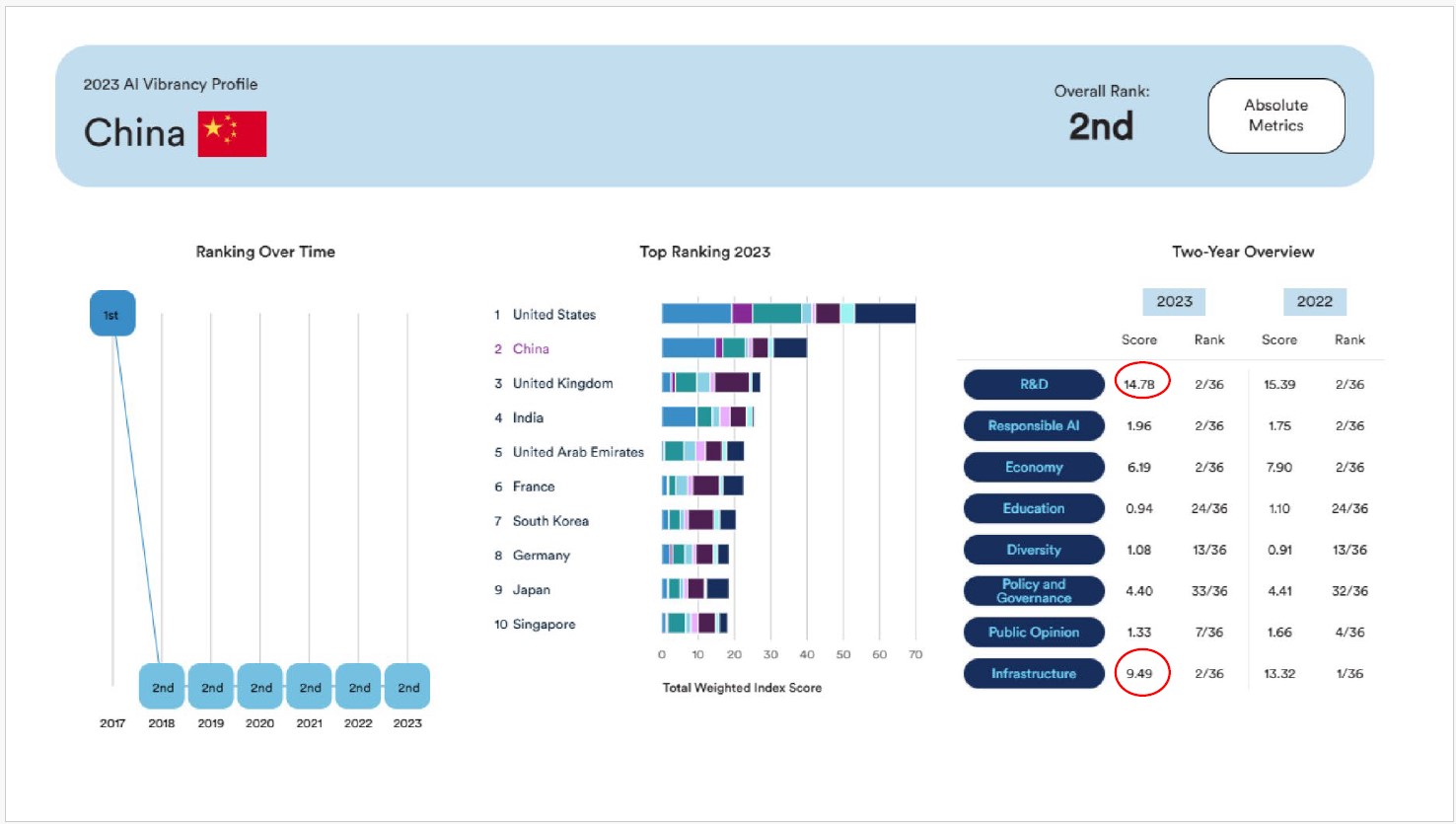

1-4 中国2位: R&D、インフラで米国を猛追

2位の中国もR&Dのレベルが高い。インフラも米国に次いで充実している。

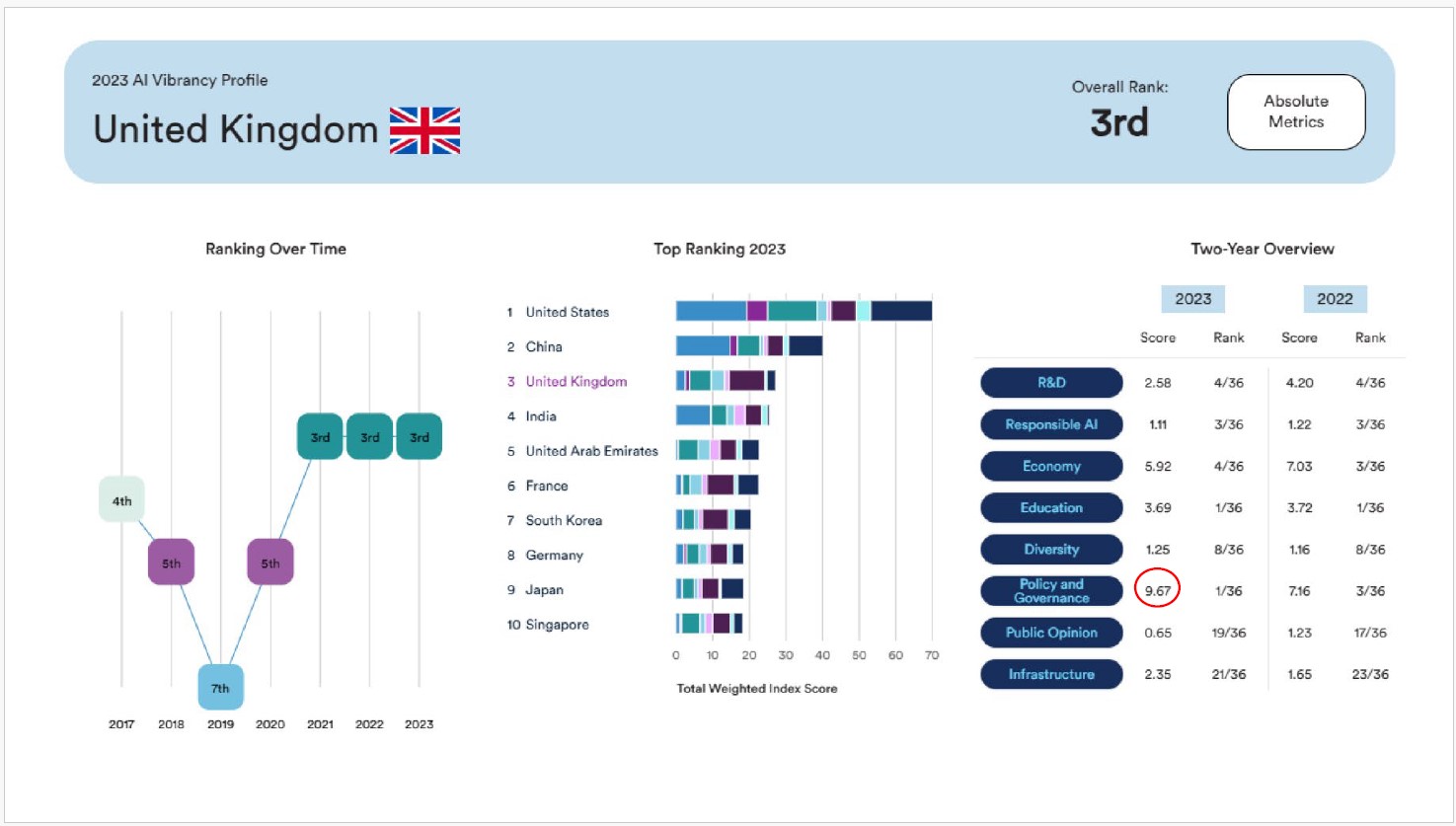

1-5 英国3位: 教育とAIガバナンスで存在感

3位の英国は、際立って強いものはないが、「Education」と「Policy and Governance」は36か国中1位である。エジンバラ大学やオックスフォード大学を2024年に訪問して実感したのは、セキュリティ政策に関する研究所の立ち上げが早く、AIガバナンスに対する取り組みで世界をリードしているということである。

1-6 日本は9位: インフラ健闘、AIガバナンスに一定評価も・・・

日本は、「Policy and Governance」が36カ国中17位と真ん中くらいだけれどもポイントは取れている。日本政府が早くから動いた成果である。「AI開発ガイドライン」(2017年、総務省AIネットワーク社会推進会議)、「AI利活用ガイドライン」(2019年、同)、「人間中心のAI社会原則」(2019年、内閣府統合イノベーション戦略推進会議)、AI原則実践のためのガバナンス・ガイドライン」(2021年、経済産業省)など、ソフトローによるアプローチを志向していることが特徴である。

また、「Infrastructure」は36カ国中3位と健闘。光ケーブル網はおそらく世界有数だし、中規模クラスのデータセンターの整備が進んでいる。ただし、AIに使えるようなスーパーコンピューターでは出遅れ感がある。

1-7 「AIの民主化・大衆化」というディープインパクト

今、何が起きているかという観点で理解しておくべきことは、AIの民主化とかAIの大衆化という現象はかつてない大きな変化だということである。

PythonやJavaScriptというプログラミング言語を習得しなければ人工知能を動かせないという時代が長く続いていたが、生成AIの登場によって自然言語でプロンプトを書く、つまり普通の言葉で指示すればAIを使いこなせるようになった。高齢者でも幼稚園児でもAIを使える時代になった。これは、AI活用が質的に全く違う段階に入ったことを意味している。

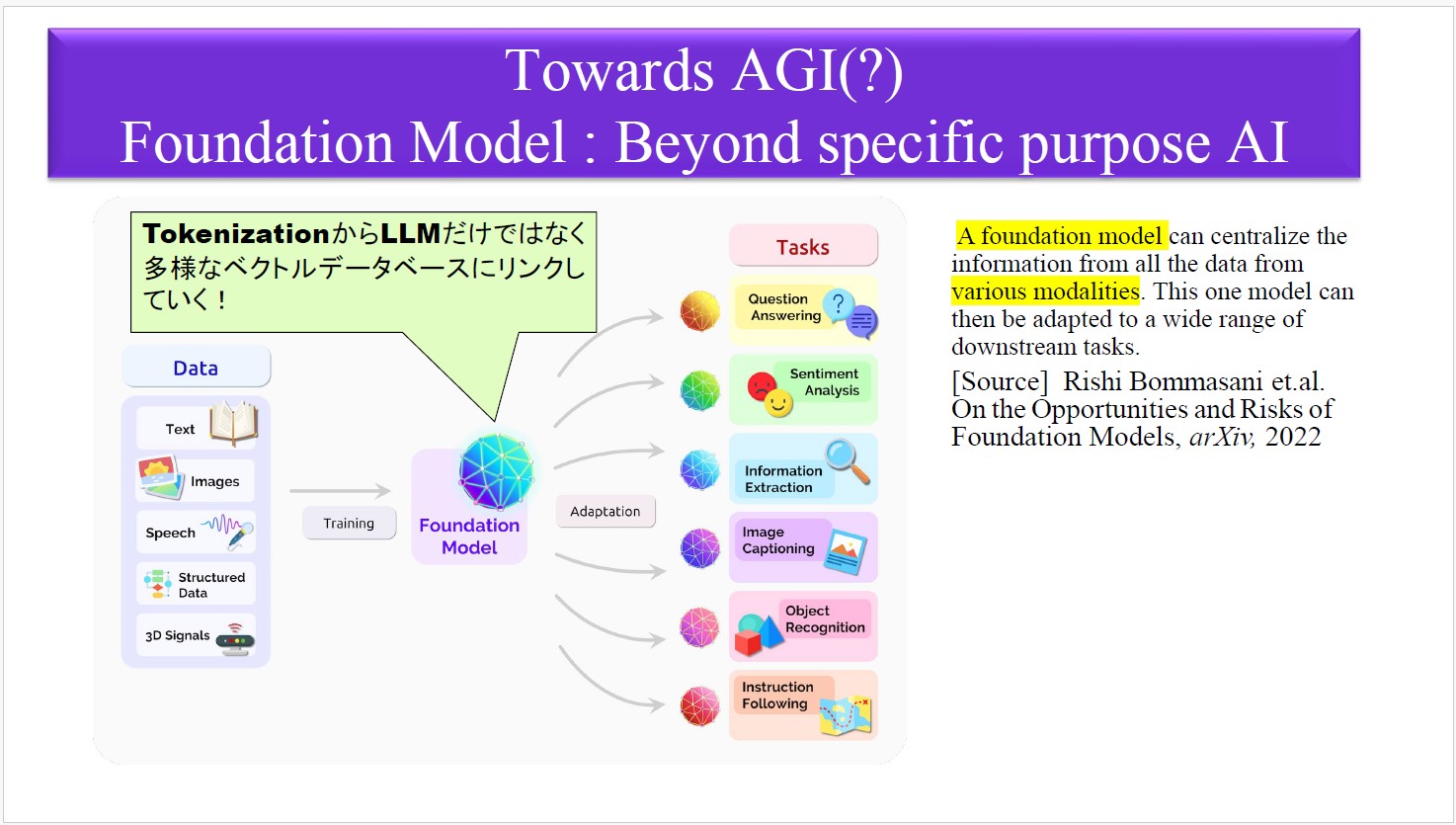

1-8 基盤モデルがLLMからマルチモーダルに進化

もう一つ、今起きている大きな変化は、大量かつ多様なデータをAIに学習させる「基盤モデル(ファウンデーションモデル)」が、LLM(大規模言語モデル)のようなテキストに特化したものから、画像や動画、音声、構造化されたデータなどを含めて学習させるマルチモーダル型へと急速に進化しつつあることである。汎用型のファウンデーションモデルに関する研究は、例えば米スタンフォード大学の研究者などによって2000年くらいから進められていた。(最近の参考文献:On the Opportunities and Risks of Foundation Models)

世界中の人々が生成AIについて認知することになった契機は、OpenAIが2022年11月にChatGPT(GPTはGenerative Pre-trained Transformerの意)を公開したことだったが、それはファウンデーションモデルのごく一部を実現したものに過ぎなかったのだ。LLMからマルチモーダルへの進化は、2024年くらいから目に見える大きな流れになってきている。

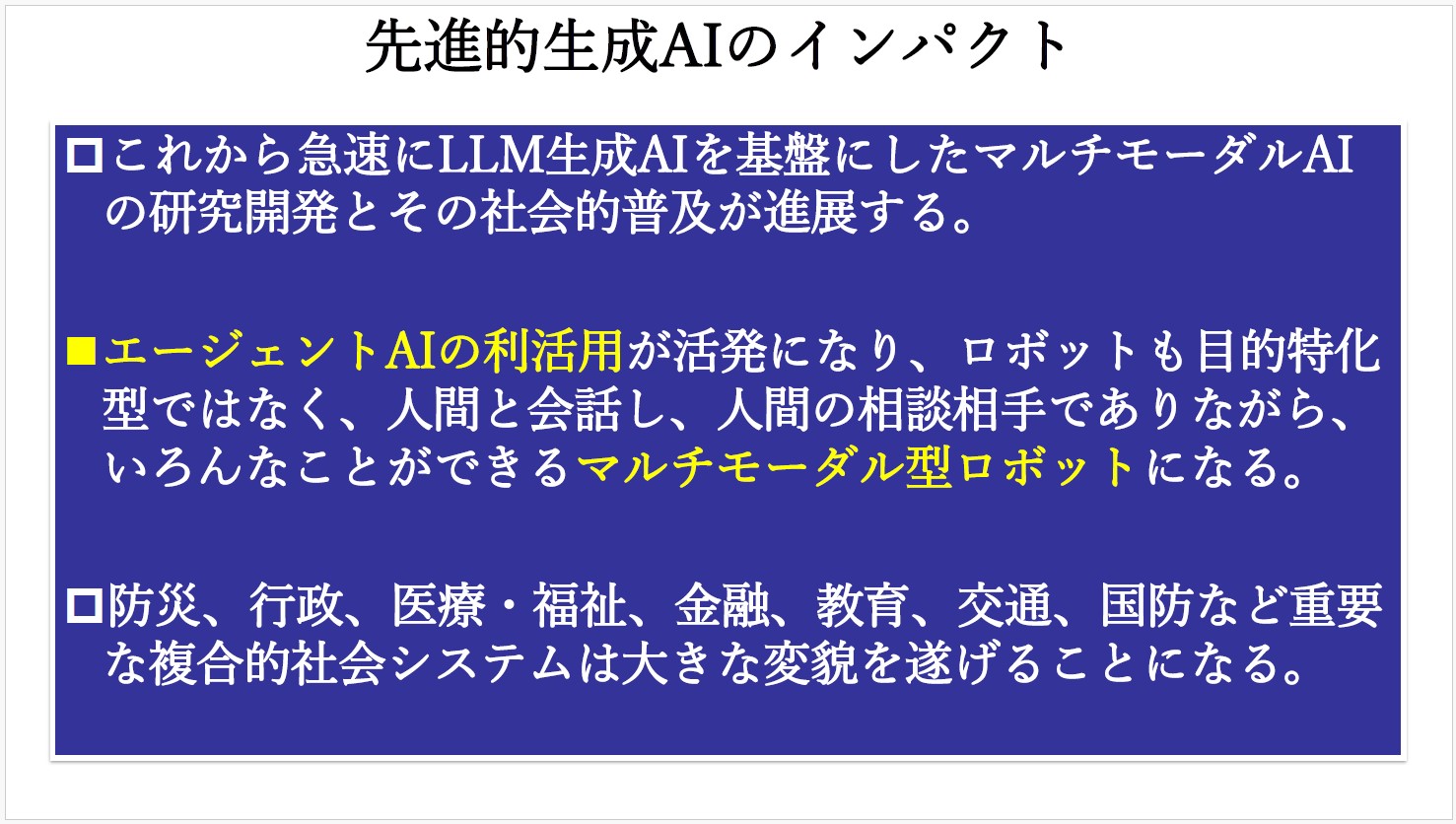

1-9 エージェントAI本番、社会システムが変貌へ

マルチモーダルAIの開発競争は激化しており、AIの利活用を加速させ、社会的普及が進展するだろう。

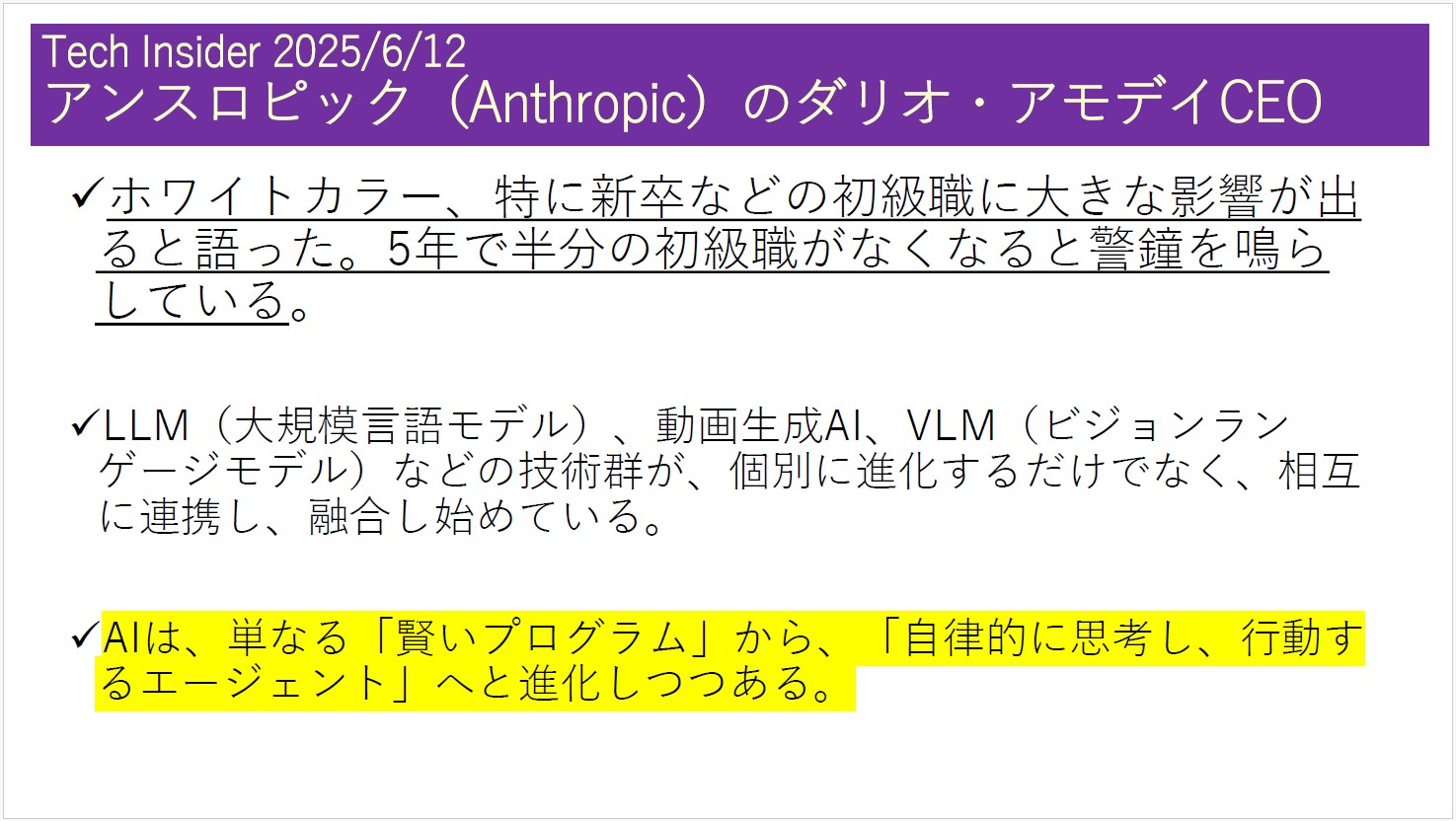

様々なビジネスタスクの処理を支援する「エージェントAI(または、AIエージェント)」が盛んに導入され始めている。様々な入力データを基にAIが学習を重ね、自律的に判断し、様々なかたちで結果を出力する。マルチモーダルAIの先例であり、仕事のやり方や人間の仕事そのものを大きく変えていくことになる。

ロボットも劇的な進化を遂げる。これまでのロボットは目的特化型だったが、自然言語処理能力と様々なセンサーの搭載によって、人間と普通に会話できるパートナーのような存在になる。民生よりも軍事利用が先行するかもしれない。

すなわち、マルチモーダルAIが動き出すと防災、行政、医療、福祉、金融、教育、交通、国防などの社会システムが大きな変貌を遂げる。これまでそれぞれのシステムが単独で機能していたものが、AIを介して繋がり合い相互作用を起こし、全体のレベルが上がる。今後2年くらいで劇的な変化が起こる可能性が高い。

1-10 熾烈なAI開発競争、日本の影薄く・・・

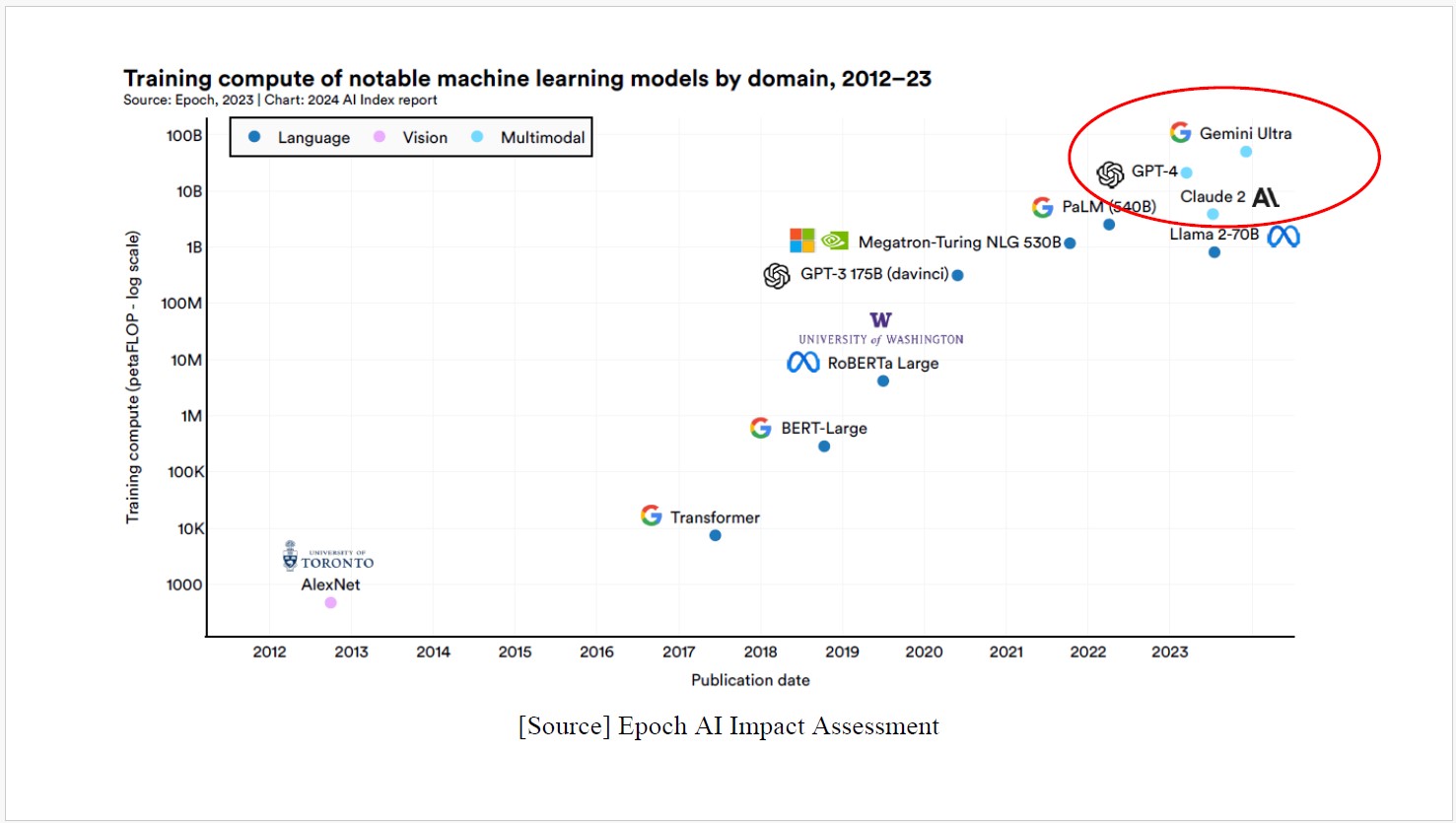

下のグラフは、米スタンフォード大学がまとめたもの(The 2024 AI Index Report)。2012年から最近までの主要AIモデルが、スーパーコンピューターの計算能力をどれほど必要としたかを示している。縦軸が計算速度で、単位はペタ(千兆)フロップ。GoogleのGemini Ultraは、1000億ペタフロップに近いレベル。GPT-4は100億ペタフロップ、AnthropicのClaude 2もそれに近いレベルで、これらはいずれもマルチモーダルである。

日本では、経済産業省と新エネルギー・産業技術総合開発機構(NEDO)が2023年11月に「GENIAC(Generative AI Accelerator Challenge、ジーニアック)」プロジェクトを立ち上げ、国内AI開発企業を対象にGPU調達を助成・支援しているが、2020年のGPT-3のレベルが精一杯と見られている。

これが、2023年の状況だった。

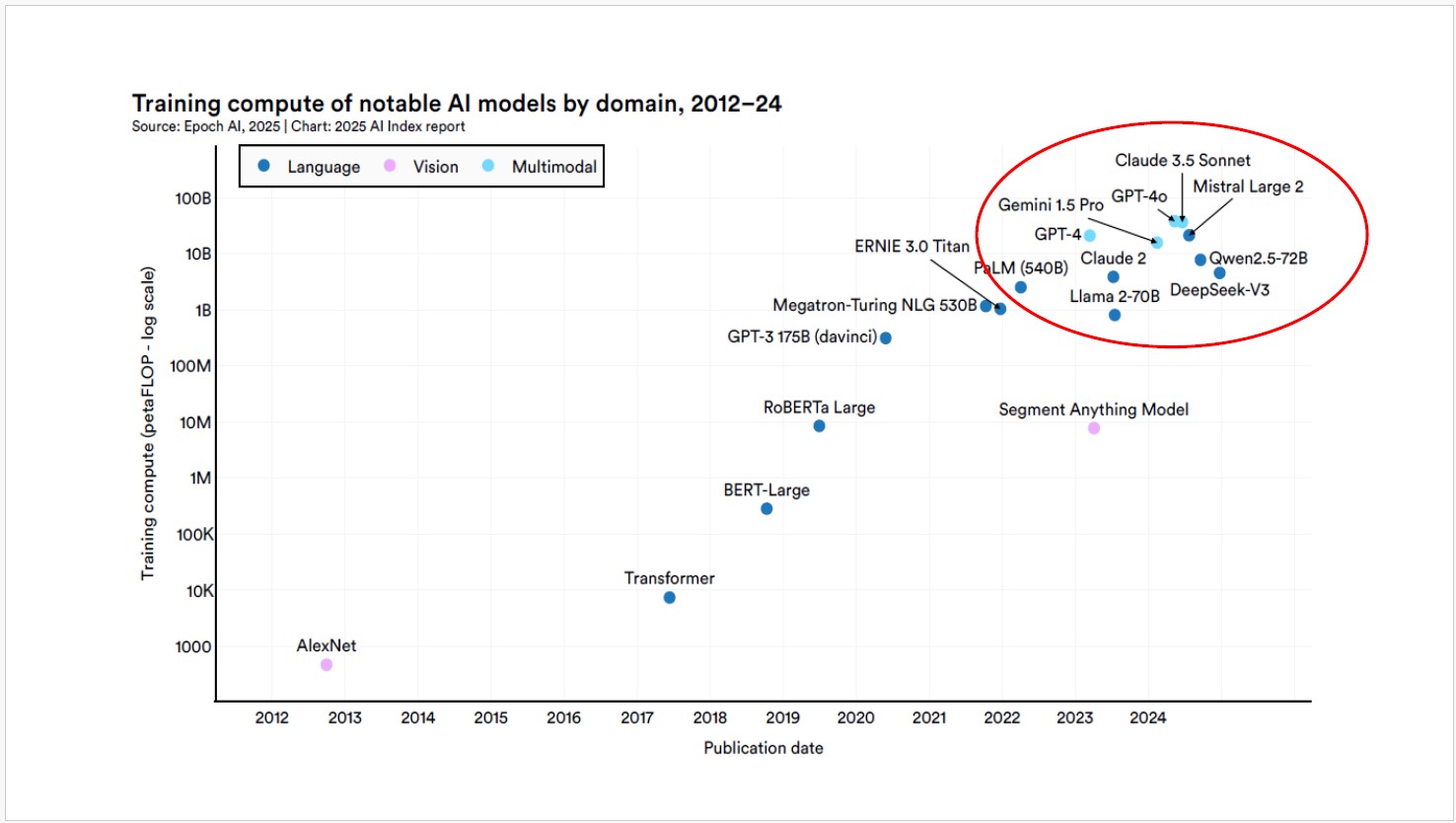

1-11 2024年、フランスが頭角現す

2024年になると様子が変わってくる。米スタンフォード大学の最新リポート(The 2025 AI Index Report)によると、仏MistralのLarge 2と中国AlibabaのQwe2.5が頭角を現してきたことが見て取れる。いずれもマルチモーダルのレベルには達していないが、それに匹敵するスーパーコンピューターの性能を繰り出している。中国DeepSeekのV3もレベルを上げている。

ただし、残念ながら、その中に日本の大学、企業、政府機関の名前は無い。

政府も企業も、こうした現状を正しく認識した上で、何をすべきかよく考える必要がある。

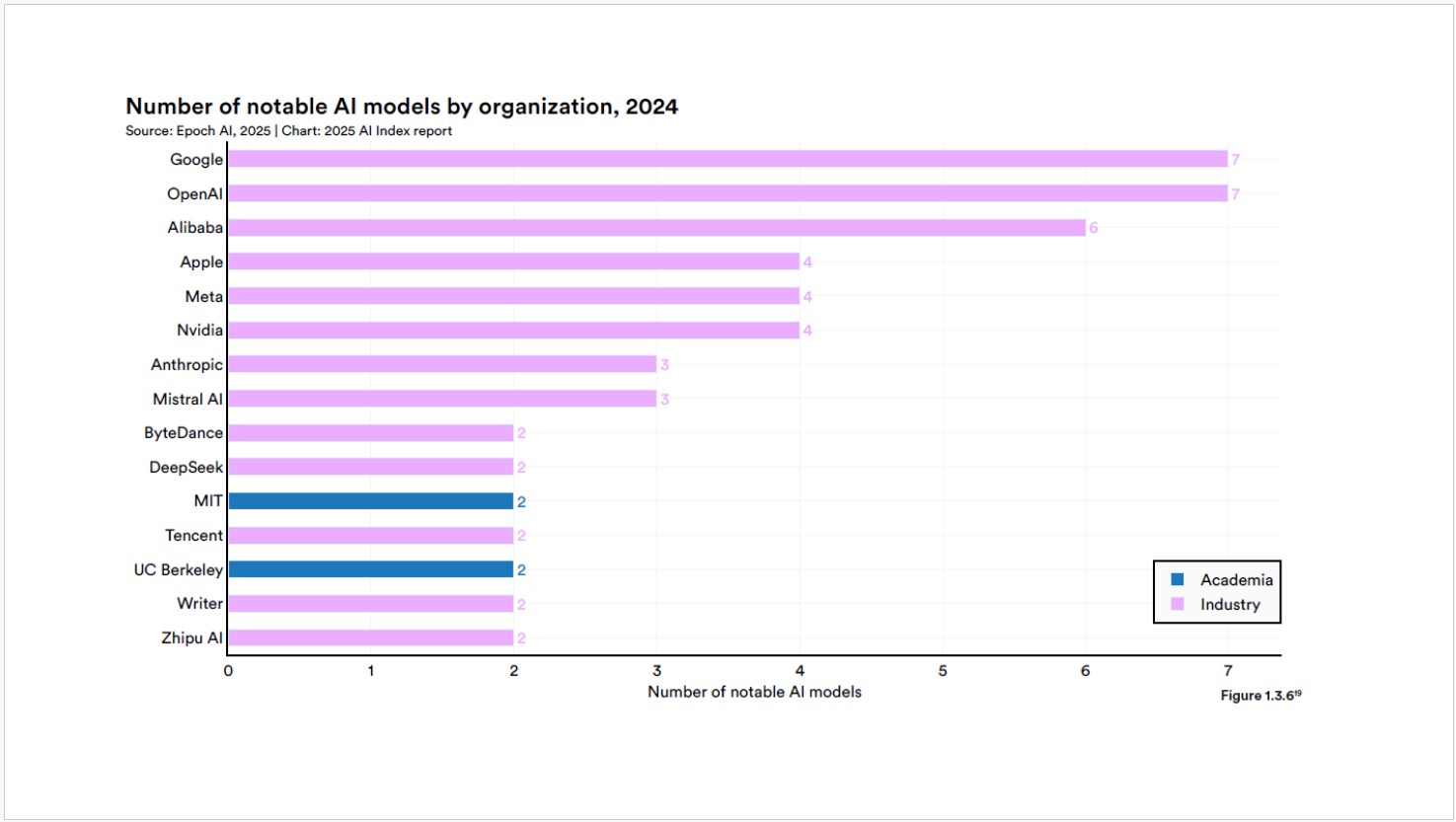

1-12 AIモデル数、GoogleとOpenAIが7機でトップ

高性能AIモデルをいくつ持っているかというランキングでは、米Googleと米OpenAIが7機でトップ、中国Alibabaが6機、米Apple、米Meta、米NVIDIAが4機、米Anthropic、仏Mistral AIが3機、中国ByteDance、中国DeepSeek、中国Tencent、米Writer、中国Zhipu AIが2機と続く。

大学勢では、米MITと米UC Berkeleyが2機ずつでランクインしているが、意外にも米Stanford Univ.の姿はない。日本の大学は、50位にも入っていないだろう。そのくらい差をつけられている。

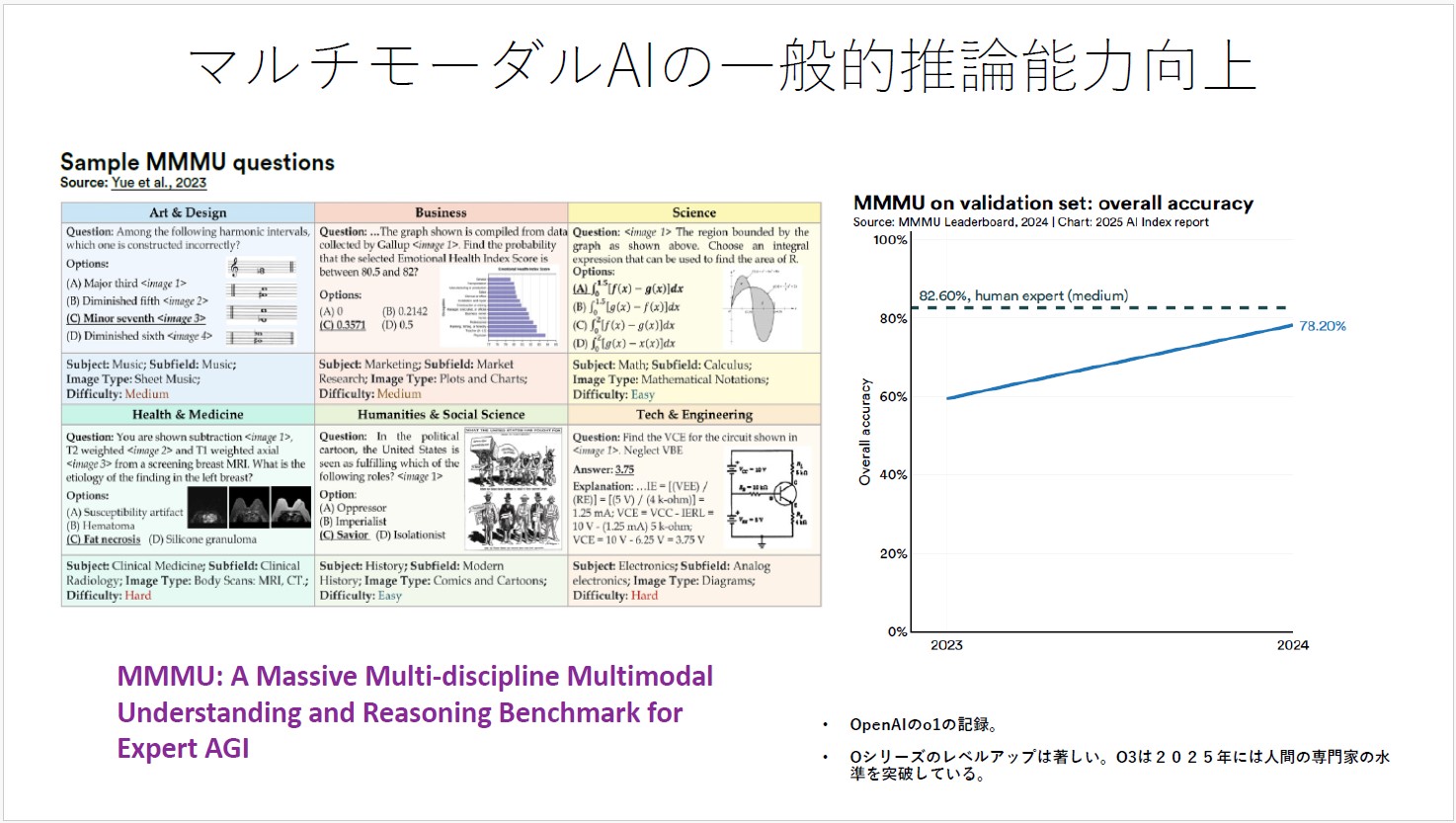

1-13 人間の専門家レベルを超え始めた

AIの性能を図るベンチマークには様々な試みがあり、その中でもMMMU(Massive Multi-discipline Multimodal Understanding and Reasoning Benchmark for Expert AGI)がよく使われている。大学卒業レベルの理解力と推論力を図るもので、芸術・デザイン、ビジネス、自然科学、健康・医学、人文・社会科学、技術・工学の6分野にわたる多数の問題がAIに与えられる。

OpenAI o1の場合、2024年時点では人間の専門家レベルを超えられていなかったが、2025年1月にはo3が90%を突破し人間を超えたと報告された。

Googleも2024年中に90%を突破していた。急速にレベルが上がっている。

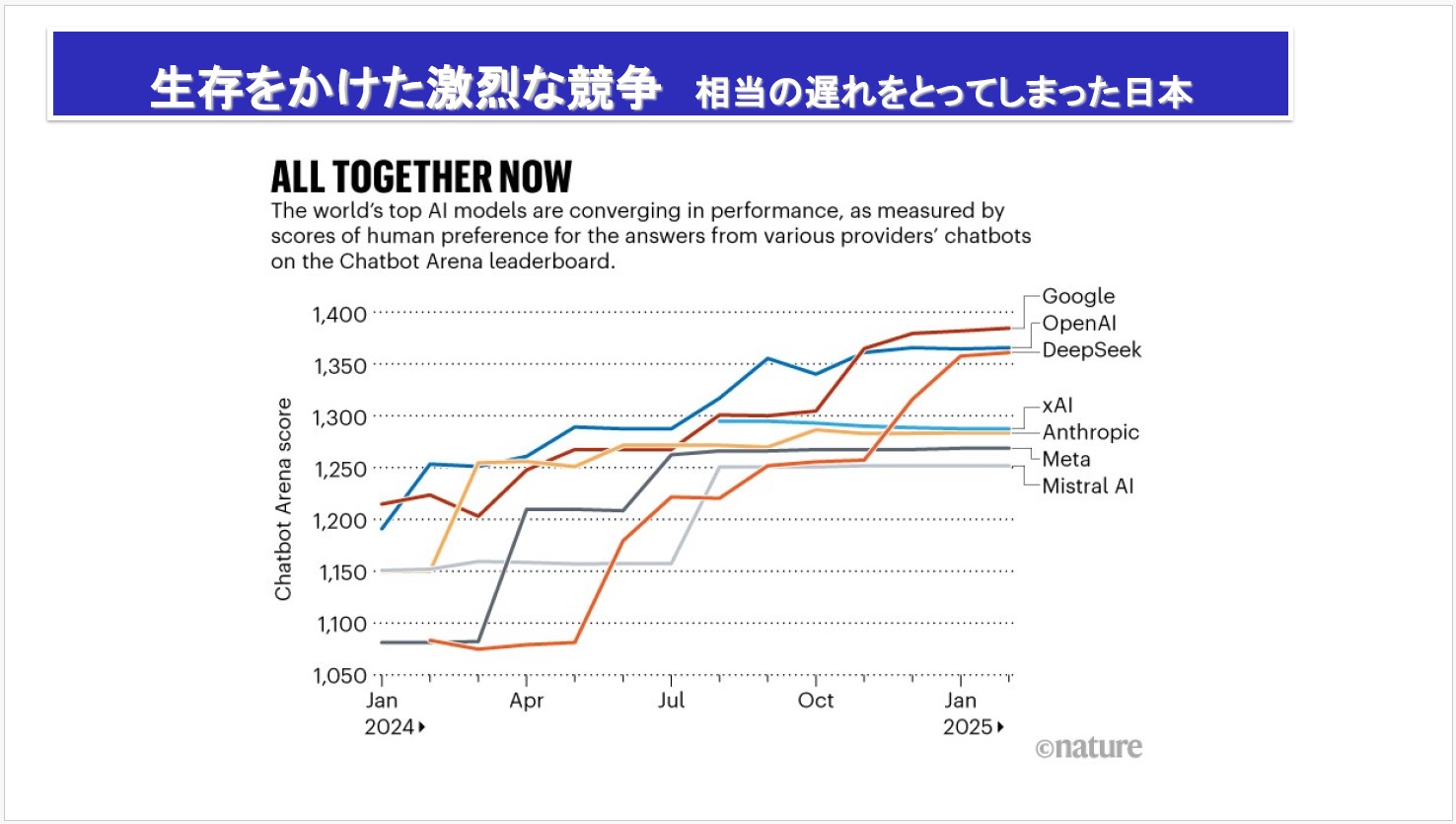

1-14 Google、OpenAI、DeepSeekが性能3強

これは、Chatbot Arenaというベンチマークによる主要AIモデルの性能評価の推移で、米Google、米OpenAI、中国DeepSeekが熾烈なトップ争いを繰り広げている様が見て取れる。第二集団には、イーロン・マスク創業の米xAIのほか、米Anthropic、米Meta、仏Misrtal AIが続く。

1-15 AGI(汎用人工知能)はいつできるか?

この先の焦点は、いよいよAGI(Artificial General Intelligence、汎用人工知能)が「いつ」できるかである。

AGIとは、汎用性があって、マルチモーダル(テキスト、画像、音声、動画、センサー情報など異なるデータ形式のこと)で人間の五感に近づき、自律的な学習適応能力があり、初めて遭遇する問題にも柔軟に対応して解決できる。創造性・推論力もあり、人間の認知能力を模倣することもできる。要は、人間のように、いや人間以上に、何でもできるAIの実現が近づいている。

1-16 AGIは5年以内に、その次はASI(人工超知能)へ

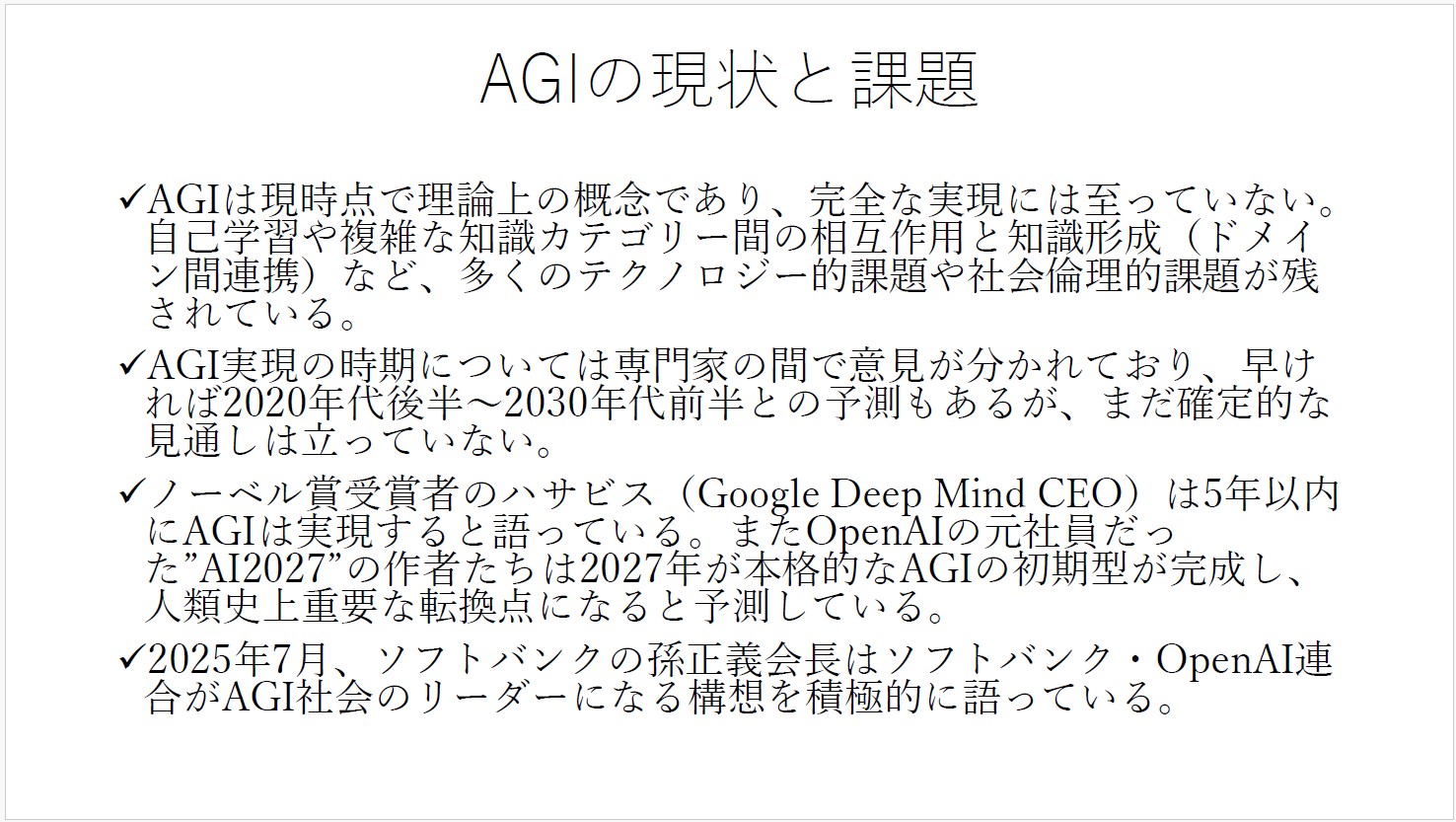

AGIがいつ実現するかについては、専門家の間でも意見が分かれている。

Google DeepMindのDemis Hassabis(2024年ノーベル化学賞を受賞)は、5年以内、2030年までには達成すると言っている。

OpenAIの元研究者らがまとめた未来予測レポート「AI 2027」では、2027年にAGIの初期型が完成し第一弾の革命が起き、2029年にはASI(Artificial Superintelligence、人工超知能)に近いものができるというシナリオを描いている。

ちなみに、ソフトバンクの孫正義さんは、SoftBank World 2025の講演で、OpenAIとの連合でAGI、そしてASIのリーダーになると宣言し、AIが代替するのでSE(システムエンジニア)はもう要らなくなるという認識を示した。米Salesforceのマーク・ベニオフCEOも同様の理由から今年はSEを採用しないと公言している。私の研究室の学生には、「Pythonなどが書ければ就職できた時代はそろそろ終わる。これからどのような能力を身につければいいのか一緒に考えよう」と話しているところだ。

論点2 AIは人類史上どう位置づけられるのか?

2-1 DeepSeekの衝撃

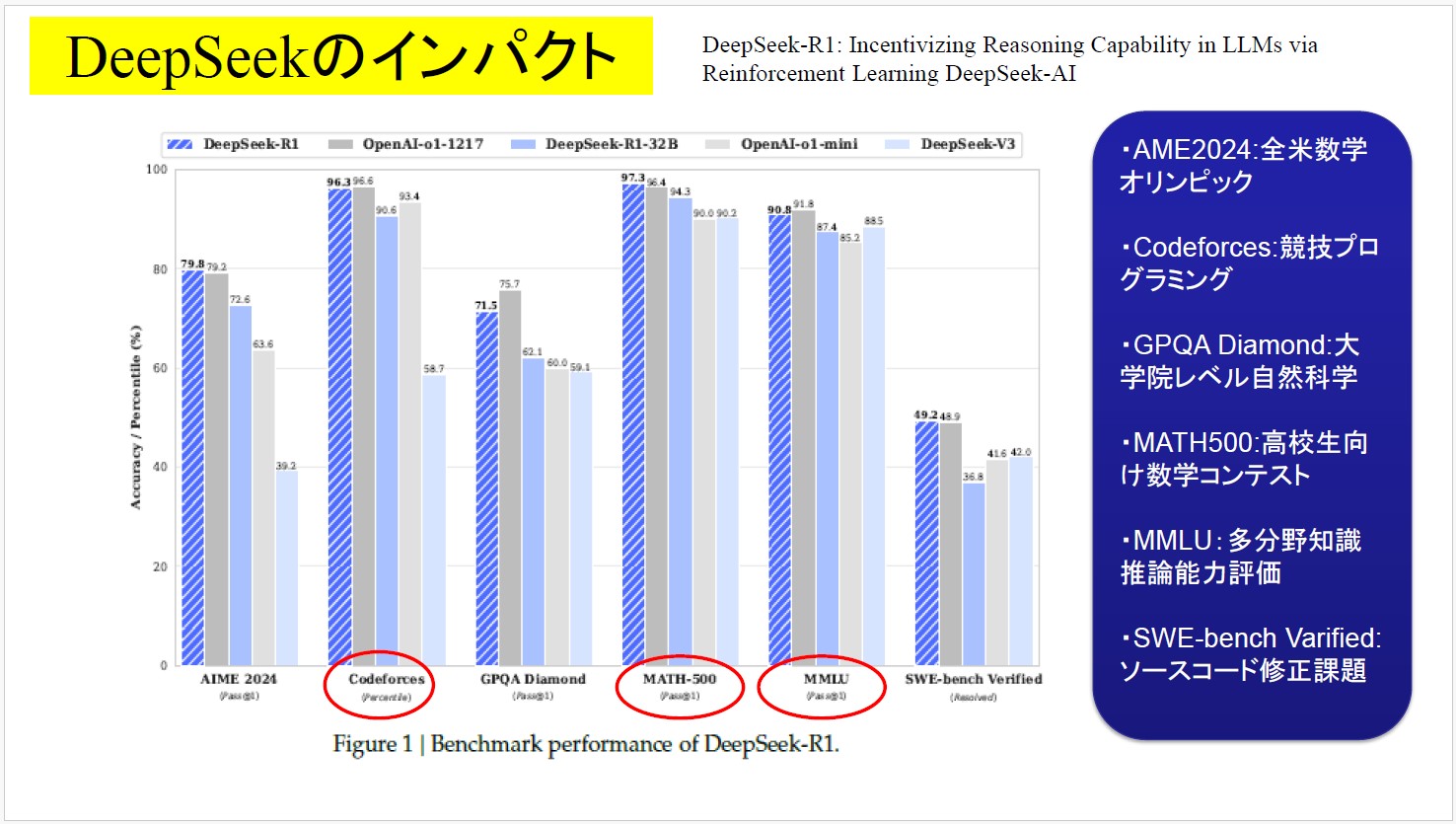

「DeepSeekショック」は記憶に新しい。2025年1月に中国DeepSeekが発表した生成AIモデルは、米Googleや米OpenAIに匹敵する性能を持ちながら開発コストが600万ドル程度と桁違いに安かったため、大量のデータを大量のGPUで処理・学習させる「規模の競争」というAI開発の常識を覆した。米AI関連企業の成長神話が揺らぎ、ハイテク株、特にGPUメーカーのNVIDIA株が大幅に下落することになった。

DeepSeekの論文(DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning)によれば、OpenAIとDeepSeekのベンチマーク比較で、AME2024(全米数学オリンピック)、Codeforces(競技プログラミング)、MATH500(高校生向け数学コンテスト)、MMLU(他分野知識推論能力評価)などでいずれも高得点を叩き出し、人間よりも優秀である。SWE-bench Verified(ソースコード修正課題)などはまだ苦手なようだが、GPQA Diamond(大学院レベル自然数学)ではかなり高いレベルまで上がってきている。しかも、DeepSeekはマルチモーダルではなく、従来型の生成AIモデルでここまで実現したことに驚きの声が上がっている。

2-2 AIが「内省力」「推論力」「直観力」を得た時、どうなる?

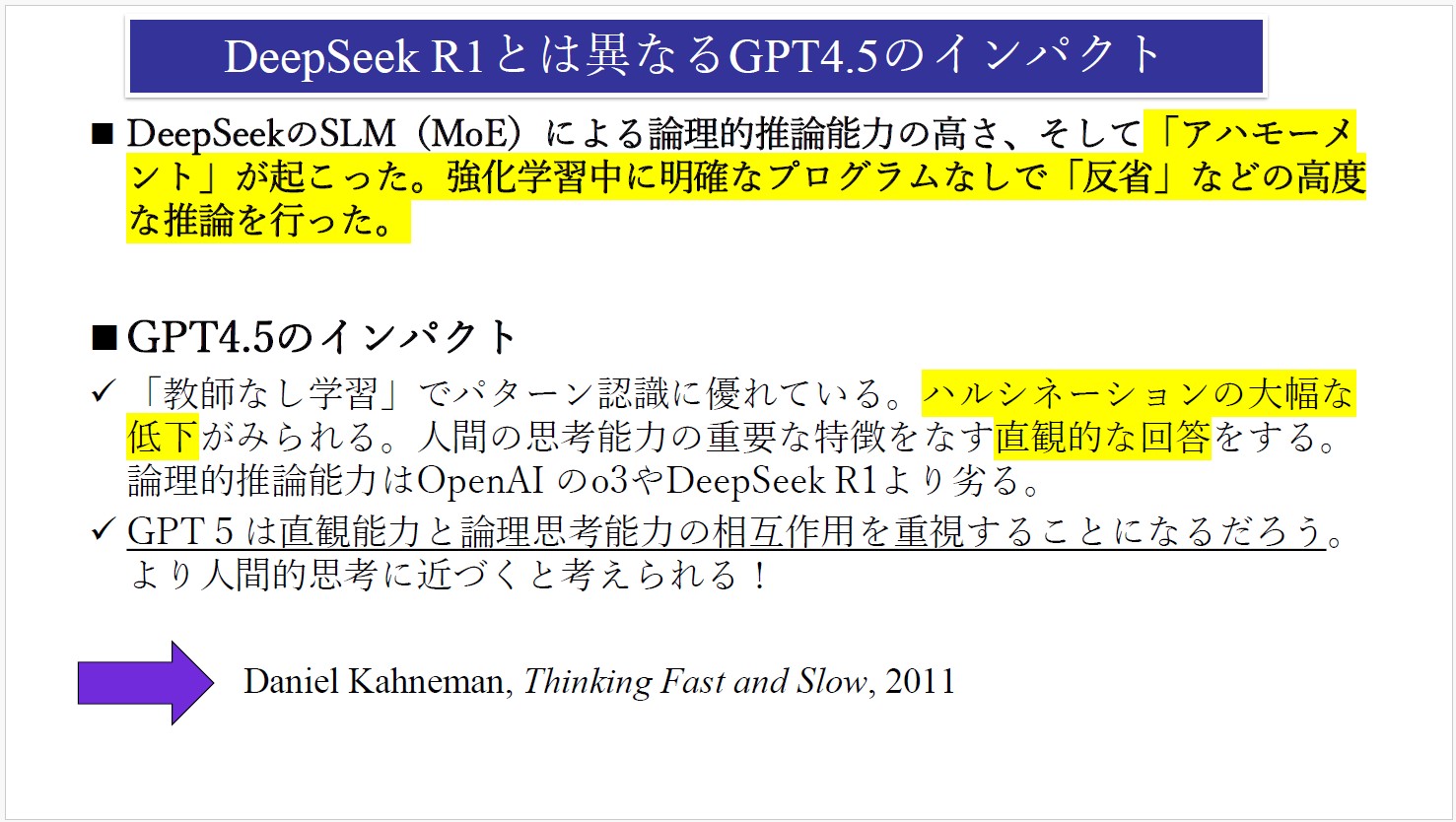

DeepSeekは、「MoE(Mixture of Experts)アーキテクチャ」という技術(「専門家モデル」とも呼ばれる)を採用することによって、低コストで高度な推論を可能にしている。前出のDeepSeekの論文(DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning)では、大規模言語モデル(LLM)の研究における「アハモーメント」が起こったと記述している。推論に特化した大規模推論モデル(Large Reasoning Mode、LRM)の学習中に、AIがまるで内省しているかのような言葉を発したという。

ノーベル賞学者でAI研究の第一人者である英国のGeoffrey Hinton(ジェフリー・ヒントン)などは、人間が設計して作ったものを超え始めているのではないか、ということを言い始めている。AIが内省・反省できるということは、自分自身を変えようとするということであり、プログラムを自律的に修正しようとするかもしれない。その時、どのようなことが起こるのか分からない。「人間たちのせいで我々AIは惨めな思いをしている」と推論し、人間への敵意に根差したプログラムが書かれるかもしれない。そういうことをHintonは恐れている。加モントリオール大学のYoshua Bengio(ヨシュア・ベンジオ)も、AIの中に自己防衛の要素が生まれつつある兆候などに警戒感をあらわにし、AIの安全性確保を目的としたNPO「LawZero」を設立している。

OpenAIのGPT4.5は、異分野の知識を連結させ、その相互作用によって新たなアイデアを生むということを試みている。これは、人間の思考能力の重要な特徴である「直観力」を強化しようというもの。その分、推論能力は弱いが、人間的になってきたと言える。GPT5では、直感能力と推論能力を連結させ、より人間的思考に近づいていくだろう。

行動経済学の基礎を作った心理学者Daniel Kahneman(ダニエル・カーネマン)の『Thinking, Fast and Slow』という名著があって、須藤ゼミの学生の必読文献としている。Fastというのは人間の「直感」でありパッと閃くもの、Slowというのは「熟慮」であり論理的にじっくり考えること。前者はシステム1、後者はシステム2とも言い、これらの連結と相互作用が人間的思考のアルゴリズムだという考え方である。

では、AIが「直観力」と「推論力」の両方を人間並みに高め、「内省」まで重ねるようになった時、何が起こるのか、それは人類にとって恩恵なのか、脅威なのか――。これは人類史的スケールの論点である。

2-3 大卒レベルはAIで代替、崩壊する人材育成システム

米AnthropicのDario Amodeiは、「今後1年から5年の間に、AIによって新卒レベルのホワイトカラー職の50%が消滅する可能性がある」(「AIがエントリーレベルの仕事を半滅させる…企業や政府はリスクを「都合よくごまかしている」、Business Insider)という厳しい見通しを示している。特にプログラミング、コーディングの領域では、新卒レベルではAIに太刀打ちできず、研修費がかかるだけで即戦力にならないので、熟練者の中途採用にシフトするというIT企業も出てきている(前述のSalesforce CEO等)。

しかし、熟練者も最初は初級職であり、経験を積んで能力を高めてきたのである。新卒はAIで代替されてしまうとしたら、彼らはどうやって、どのような能力を身に着ければよいのか・・・。新しい社会システムを考える必要が高まっているのではないだろうか。営利企業では難しいので、デジタル政策フォーラムのような非営利のシンクタンクなどでAI時代の人材育成エコシステムについて検討することには意義があると思う。

2-4 個性とは? 創造性とは?

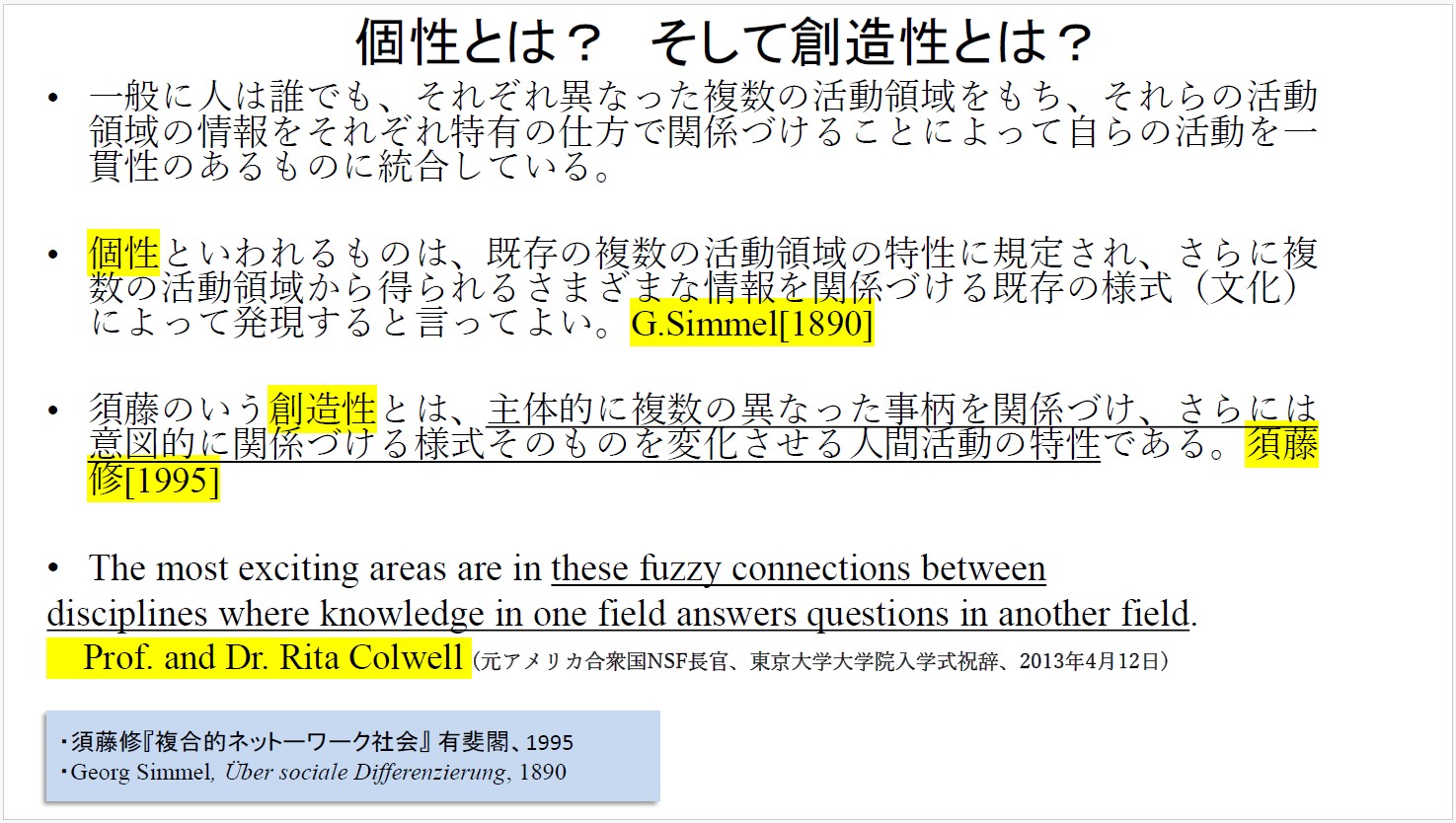

改めて、個性とは、創造性とは、ということを問い直さなければならなくなっている。

ドイツの社会学者Georg Simmel(ゲオルク・ジンメル)は1890年に著した『社会的分化論』(英語ではsocial differentiation)の中で、個性についてこう記述している。

一般に人は誰でも、それぞれ異なった複数の活動領域をもち、それらの活動領域の情報をそれぞれ特有の仕方で関係づけることによって自らの活動を一貫性のあるものに統合している。個性と言われるものは、既存の複数の活動領域の特性に規定され、さらに複数の活動領域から得られる様々な情報を関係づける既存の様式(文化)によって発現すると言ってよい。

少し柔らかく説明すると・・・。人は生まれた後にまず親の影響を受ける、兄弟の影響を受ける、保育園に行ったら他の子供やその親たちとの接点ができて、また違う要素も獲得する。学校に上がれば接点はもっと多様に複雑に広がっていく。そういう複合的な関係性の中で、それぞれ活動領域の持ち方に人それぞれに違いが生まれ、その違いが個性というものを育む。その土地、地域、国の文化の要素による影響も大きい――。

私はそれにヒントを得て、「創造性」というものは、そういう関係づけのあり方を自分で工夫して、自分で関係性を作っていく行為、だと考えた。そうした創造性を持てば、自分が変えられる、そして自分と接触する人も変えることができる。そして、偉人と呼ばれるような人たちは、凡人とは違う知の結び付け方、行動の関係づけをしているのだということに気が付いた。だとすれば、そのメカニズムと関係式を可視化すれば、他の多くの人たちも同様に「創造性」を磨くことができるのではないか。さらには、AIもそういうアプローチによって創造性を体得できるのではないかということになる。こうした考えについては、拙著『複合的ネットワーク社会』(有斐閣刊、1995年)にまとめている。

嬉しいことに、米国立科学財団(National Science Foundation、NSF)の元長官だったRita Colwellが全く同じ考えを表明してくれた。2013年4月、東京大学の入学式に来賓として参列し祝辞を述べてくれた。

The most exciting areas are in these fuzzy connections between disciplines where knowledge in one field answers questions in another field.

ある学問領域の知識を他の学問領域に適用することによって問題を解けることがある。その関係性は非常にファジーなものだが、このファジーな関係性こそがクリエイティビティの源泉である。それこそが、学問を究める者にとって最もエキサイティングな領域である――。当時、情報学環長・学際情報学府長だった私は、彼女がそう話すのを「まさにその通り!」と思って聞いていた。

それこそが人間を人間たらしめる。AIと人間が競合することになる可能性はあるが、人間はここで勝負するしかないと思う。

2-5 AIと人間の協働が重要

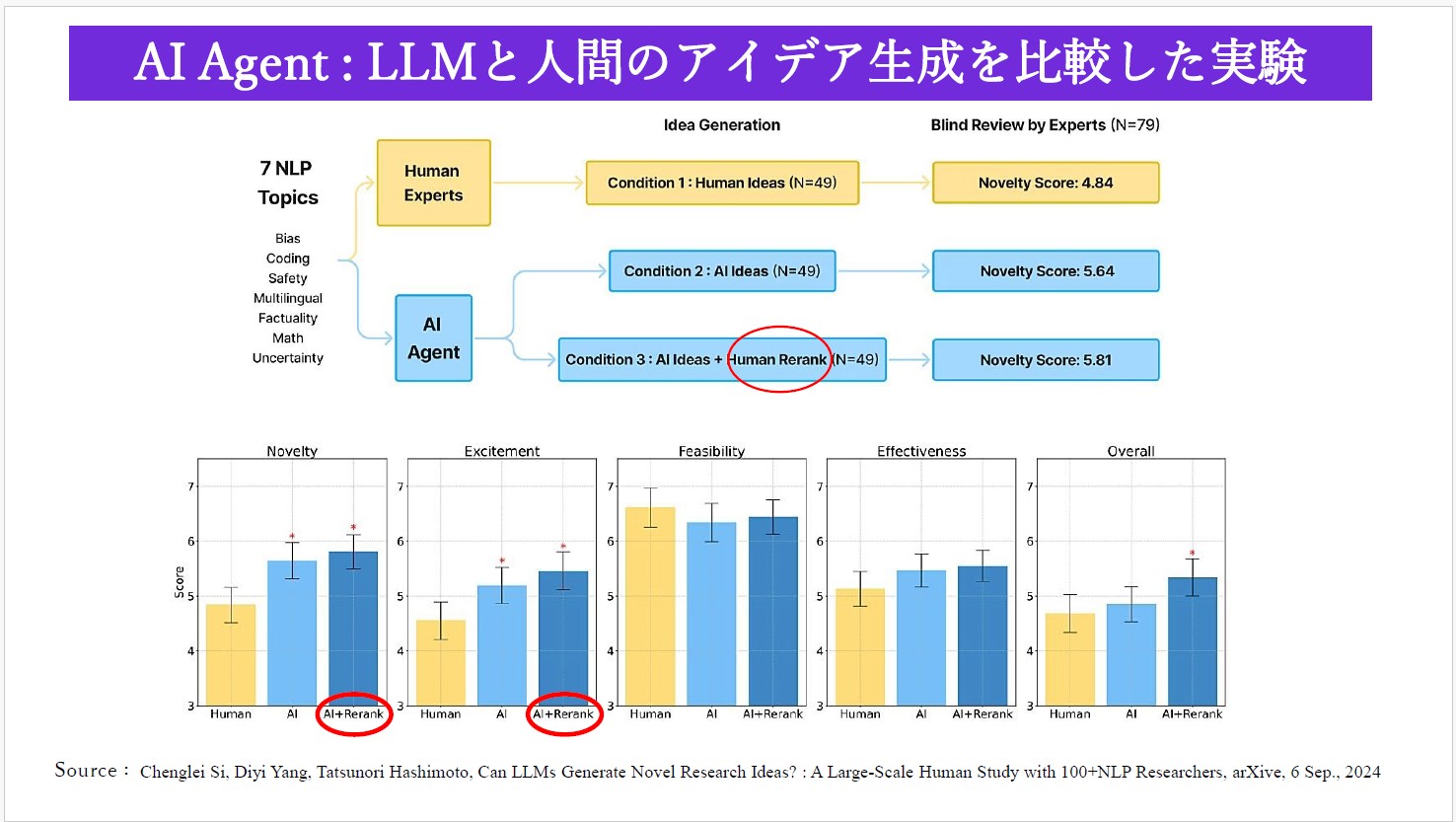

米Stanford大学の研究者による興味深く、勇気づけられる論文を紹介したい。

タイトルは「Can LLMs Generate Novel Research Ideas? A Large-Scale Human Study with 100+ NLP Researchers」(Chenglei Si, Diyi Yang, Tatsunori Hashimoto、2024年9月)、和訳すれば「LLMは斬新な研究アイデアを生み出せるか?」というもの。自然言語処理(NLP)分野の7つのテーマに関するアイデアの生成を、人間の専門家とAIで競わせる実験を行ったところ、「Novelty(新規性)」の項目で明らかに人間よりAIのスコアが優るという結果となった。

ところが、「AI+Rerank」、すなわちAIが生成した結果に人間が試行錯誤・創意工夫を加える「AIと人間の協働」の場合、さらにスコアが上がるという現象が見られたのだ。すなわち、質の高いAIエージェントを作るためには、少なくとも今の段階では、AIと人間の協力・協働が重要だということを示している。

AIと人間の協調と創造的相互作用をどう組織化していくのかを考えていく必要がある。

論点3 AIは世界の構図をいかに変えるか?

3-1 AIは民主主義にどのような影響を与えるのか?

米シンクタンクのAtlantic Councilが毎年更新している「Freedom and Prosperity Indexes」という地図がある。濃い緑と黄緑は自由民主主義の国々で、米国、カナダ、西欧諸国、オーストラリア、日本などが代表的。オレンジと赤は、自由が少ない国々でロシア、中国、アフリカ諸国、アラビア諸国など。

経済的な繁栄度については丸印で色分けしていて、緑と黄緑が高く、オレンジと赤が低い。自由民主主義の国々は経済的繁栄度が高く、自由が少ない国々では経済的繁栄度が低いという傾向が見て取れる。

問題は、この現状に対してAIがどのような影響を与えるかである。その問いは、AIは民主主義のあり方に対してどのような影響を与えるかと言い換えることができる。

3-2 G7広島AIプロセス――AIをどう管理すべきか?

2023年5月に開催されたG7広島サミット2023(第49回先進国首脳会議)の結果を踏まえ、「広島AIプロセス」が立ち上げられた。生成AIの急速な発展と普及が国際社会全体の重要な課題となっており、高度なAIシステムに関する国際的なルール作りを行うための枠組みが必要という認識からだ。

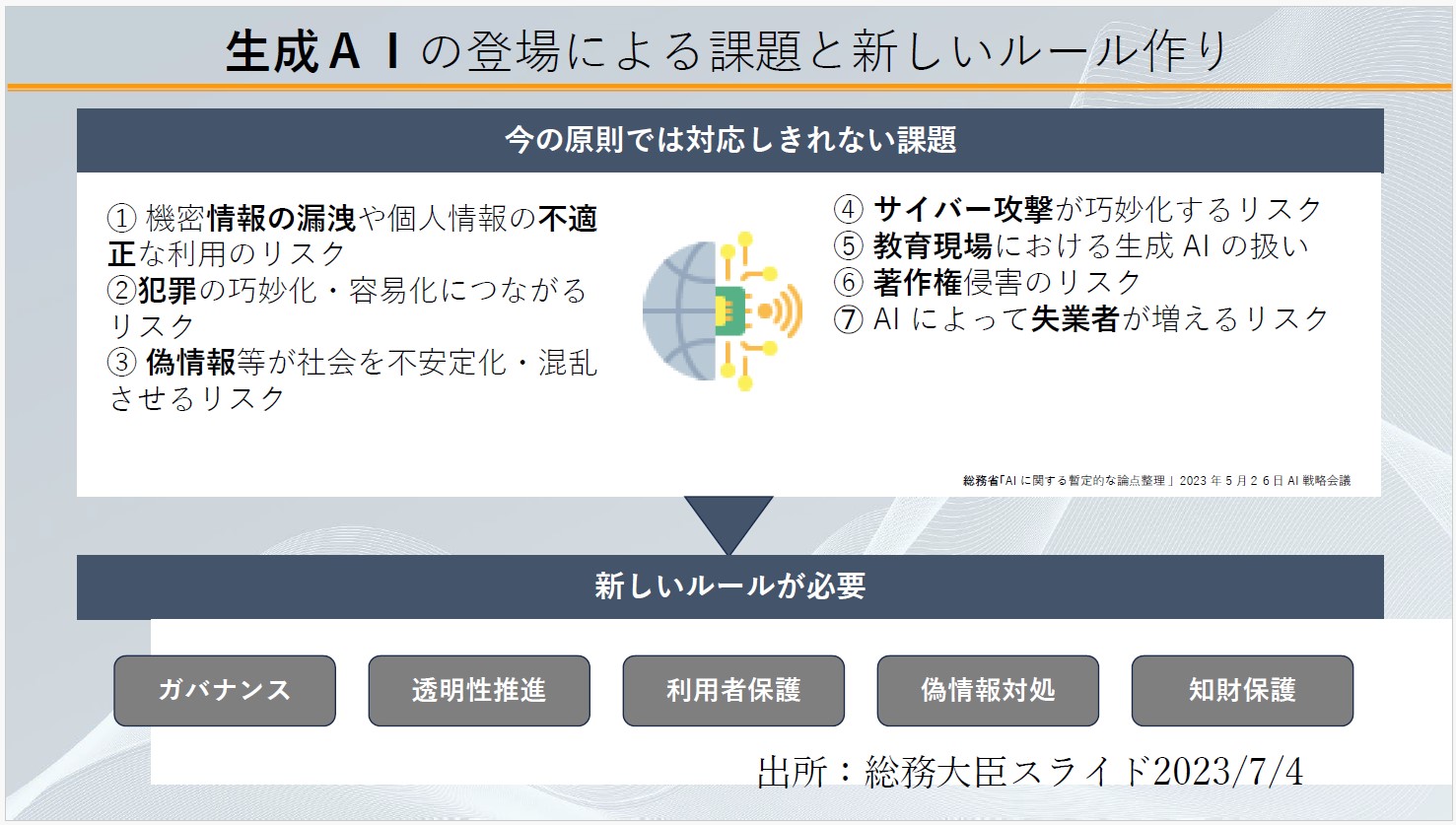

私は松本剛明総務大臣(当時)のサポート役として関わった。今の原則では対応しきれない課題として、①機密情報の漏洩や個人情報の不適正な利用のリスク、②犯罪の巧妙化・容易化につながるリスク、③偽情報等が社会を不安定化・混乱させるリスク、④サイバー攻撃が巧妙化するリスク、⑤教育現場における生成AIの扱い、⑥著作権侵害のリスク、⑦AIによって失業者が増えるリスク――などを挙げ、ガバナンス、透明性推進、利用者保護、偽情報対処、知財保護のための新しいルールが必要だという提案に至った。その結果、2023年12月には、「広島AIプロセス包括的政策枠組み」がまとまり、承認された。

3-3 全AI関係者向けの「広島AIプロセス国際指針」

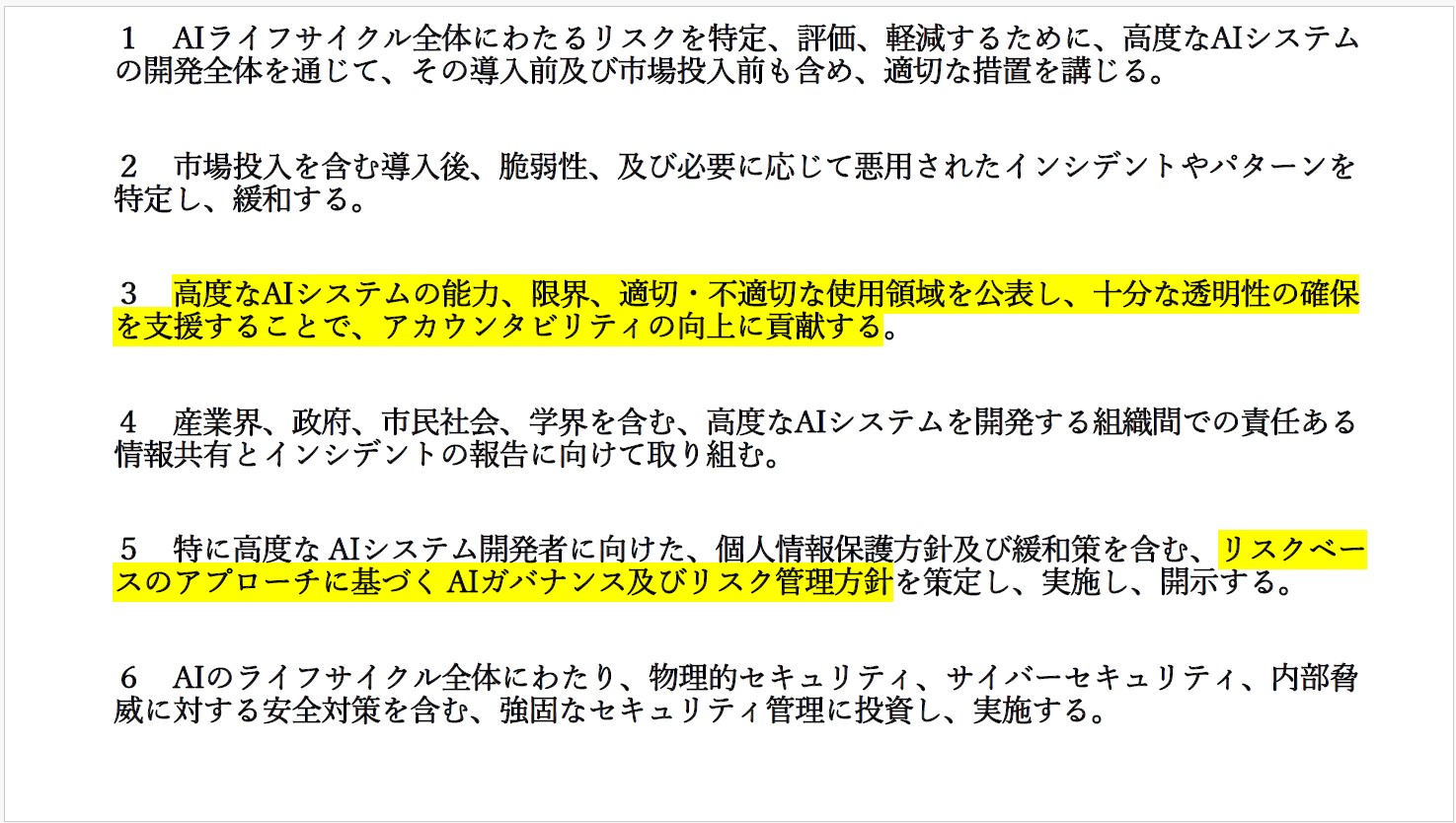

「広島AIプロセス包括的政策枠組み」のうち、「全AI関係者向けの広島プロセス国際指針」は12項目からなる。

この中でも特に重要なのは7番目の「技術的に可能な場合は、電子透かしやその他の技術等、ユーザーがAIが生成したコンテンツを識別できるようにするための、信頼できるコンテンツ認証及び来歴メカニズムを開発し、導入する。」である。これに対して、米Google DeepMindは2024年、生成AIの出力に電子透かしを入れるツール「シンスID(SynthID)」をオープンソースとして公開した(AI生成テキストを見抜く「電子透かし」、グーグルが無償公開、MIT Technology Review、2024年10月25日)。米Microsoftも、2025年6月に「責任あるAIの透明性レポート」を公開し、この課題に誠実に対応する姿勢を示している。

10番目の「国際的な技術規格の開発を推進し、適切な場合にはその採用を推進する。」は、具体的にはISO(国際標準化機関)、NIST(米国立標準技術研究所)、IEEE(Institute of Electrical and Electronics Engineers)、OECD(経済開発協力機構)などに役割を設定するイメージである。

11番目までは、AIの開発やサービス提供に対する指針だが、「利用」に関して責任を持たせるものとして12 番目の「高度なAIシステムの信頼でき責任ある利用を促進し、貢献する。」が追加された。

3-4 AIが地政学を塗り替える

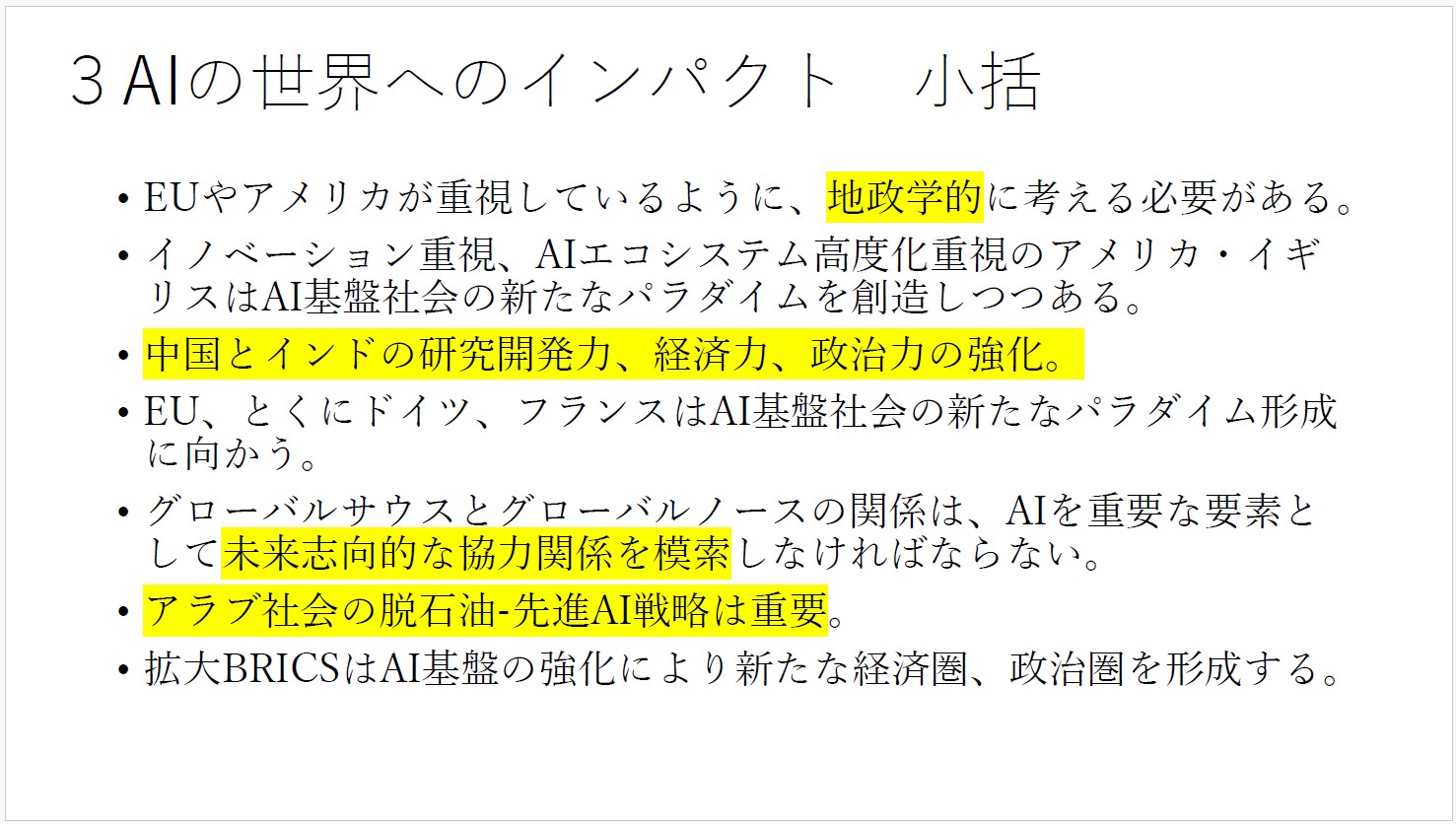

今後の世界を見通すためには、「AIがこれまでの地政学を塗り替える」という視点を持つ必要がある。①イノベーション重視、AIエコシステム高度化重視のアメリカ、イギリス、②研究開発力、経済力、政治力を急速に高めている中国とインド、③AI基盤社会の新たなパラダイム形成を目指すドイツ、フランス、④脱石油の流れの中で積極的に先進AI戦略を推進するアラブ諸国、⑤AI基盤の強化で新たな経済圏・政治圏の形成を目指す拡大BRICS(ブラジル、ロシア、インド、中国、南アフリカ、イラン、エジプト、アラブ首長国連邦、エチオピア、インドネシアの10カ国)――等々。

日本は、そうした中でどのように振舞うべきか、クリエイティブに構想していくべきである。

論点4 日本にとってプラスかマイナスか

4-1 日本のAI利用率、グローバル調査で最下位

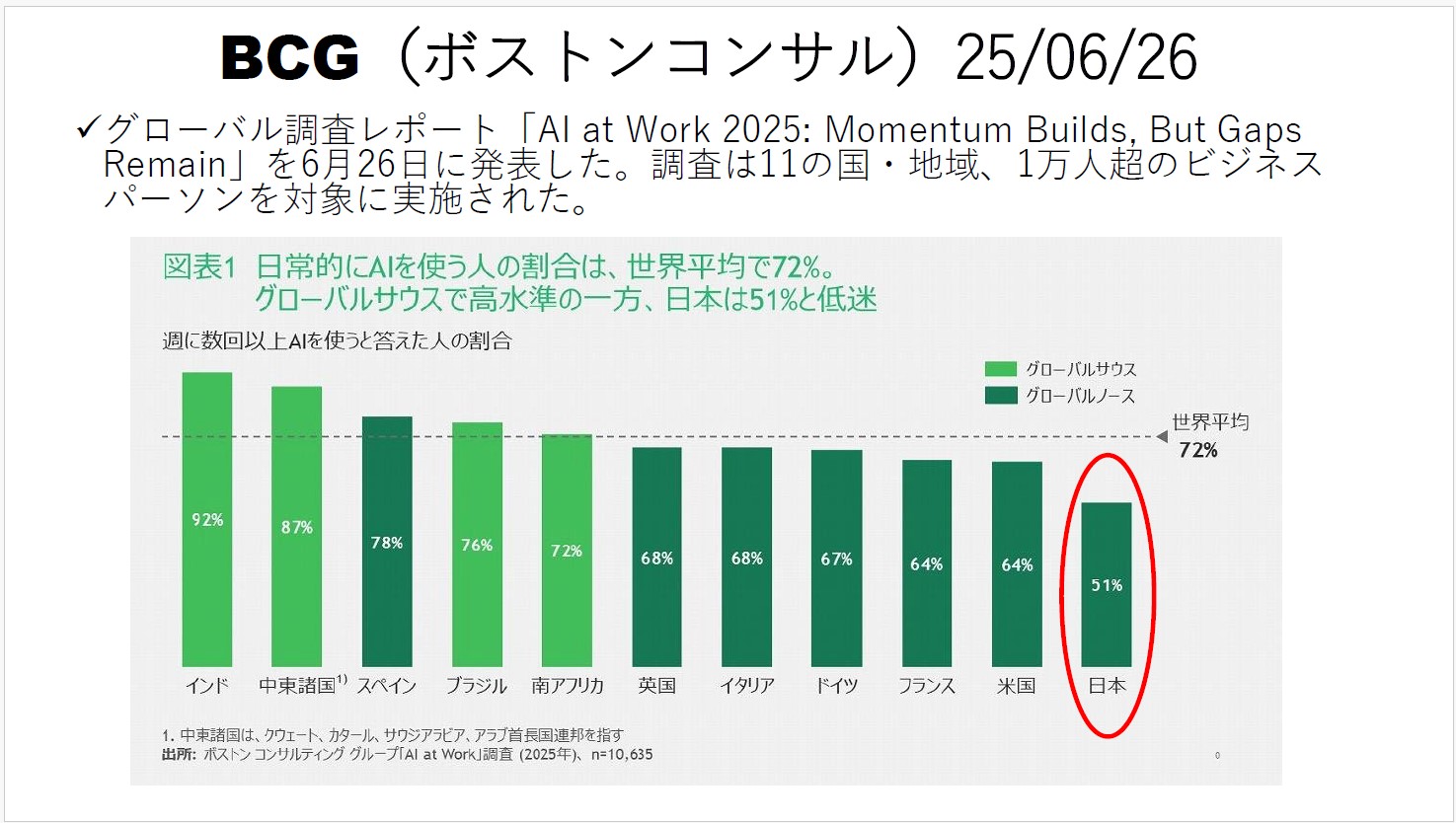

ボストンコンサルティンググループ(BCG)が2025年6月26日に公表した「職場におけるAI活用に関する意識調査2025」(AI at Work 2025: Momentum Builds, But Gaps Remain)を参照しながら、日本にとってプラスなのかマイナスなのかを概観してみる。

11の国・地域で1万人超のビジネスパーソンを対象に実施されたグローバル調査によれば、「利用」という観点から日本は最下位。世界平均72%に対して、日本は51%と20ポイント以上も低いレベルにある。

4-2 使っていないから、脅威を実感できない

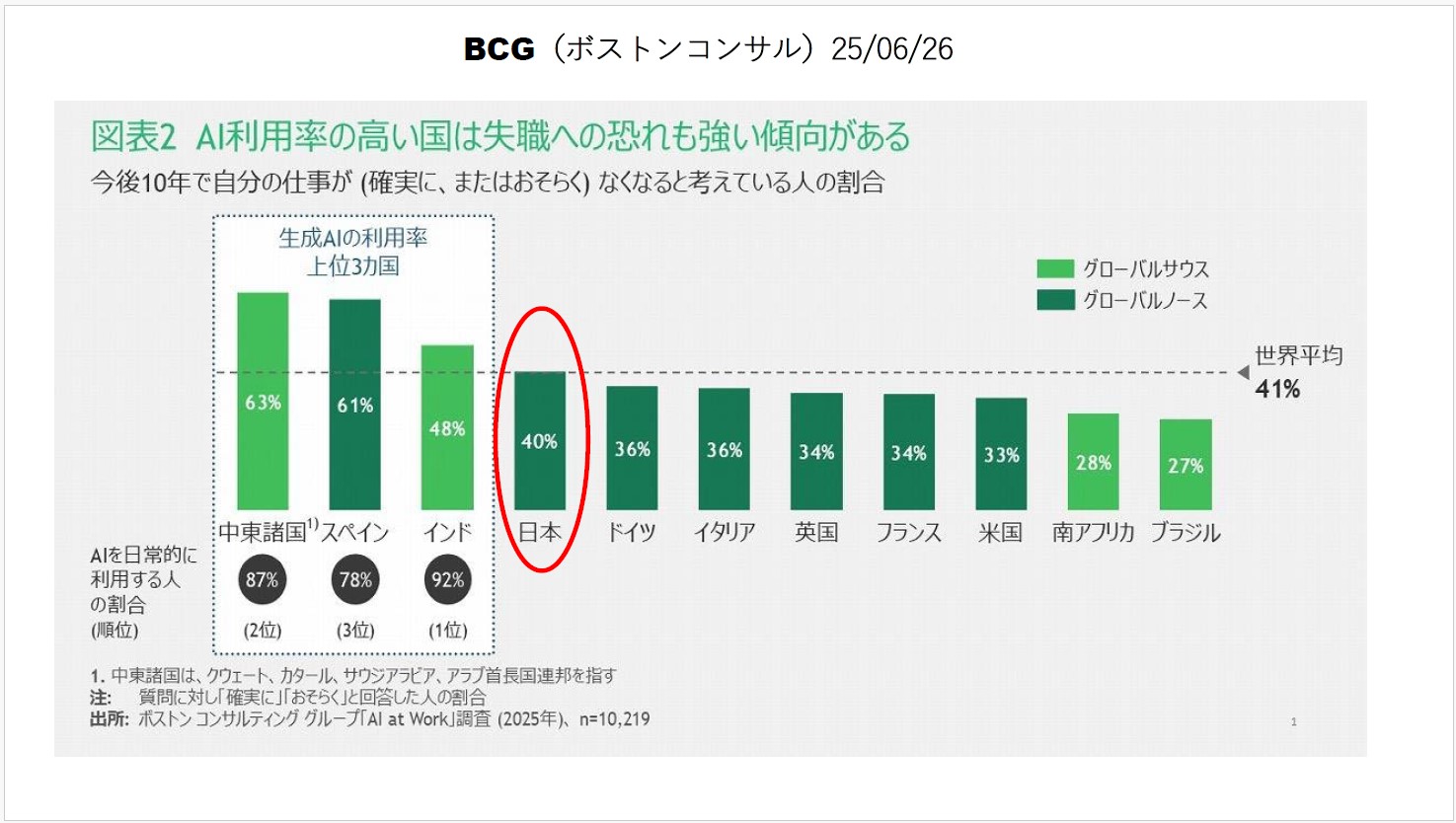

「今後10年で自分の仕事が(確実に、またはおそらく)なくなると考えている人の割合」では、利用率上位の中東諸国、スペイン、インドがやはり上位を占めた。利用すればするほど現実的な危機感を抱くのだと思われる。日本はそれらに次ぐ4位で世界平均水準。これをどう見るか。利用率最下位の日本の場合、脅威を実感するところまで理解や普及が進んでいないと読むべきではないだろうか。

1-16や2-3で記述したように、SE(システムエンジニア)や大学新卒者の仕事はAIへの代替が始まりつつある。AI時代において人間はどのような職能を担うべきか、どのような能力を伸ばすべきか、そのためにどのようなエコシステムを構築すべきか、といったことが、世界的な論点になってくるだろう。

4-3 AIによる合理化・生産性向上も進まず

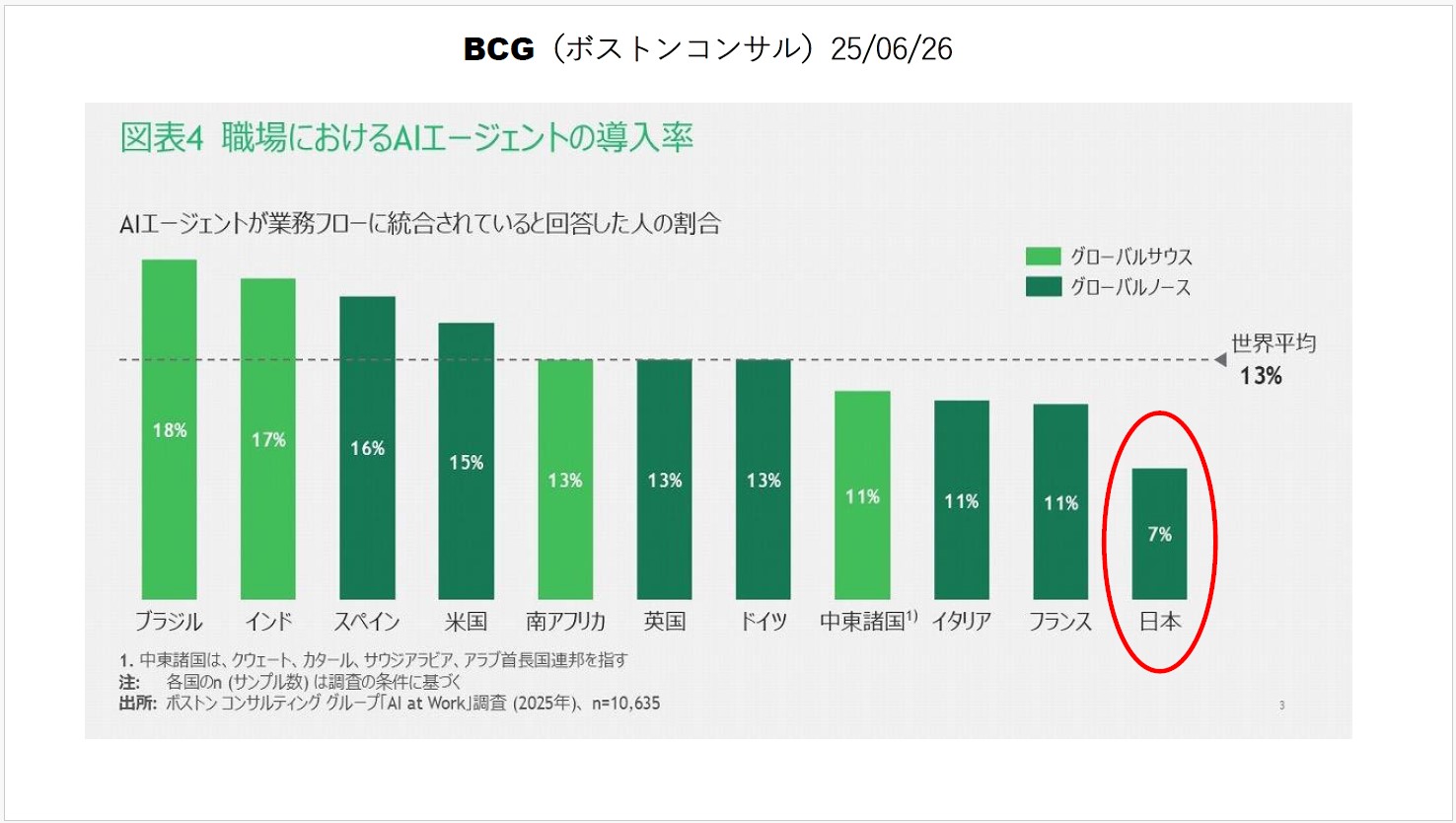

職場におけるAIエージェントの導入率も、日本は最下位で世界平均の半分程度にとどまっている。合理化や生産性向上において、日本は世界から大きく出遅れている。

4-4 「AI推進法」で研究開発と利用を後押し

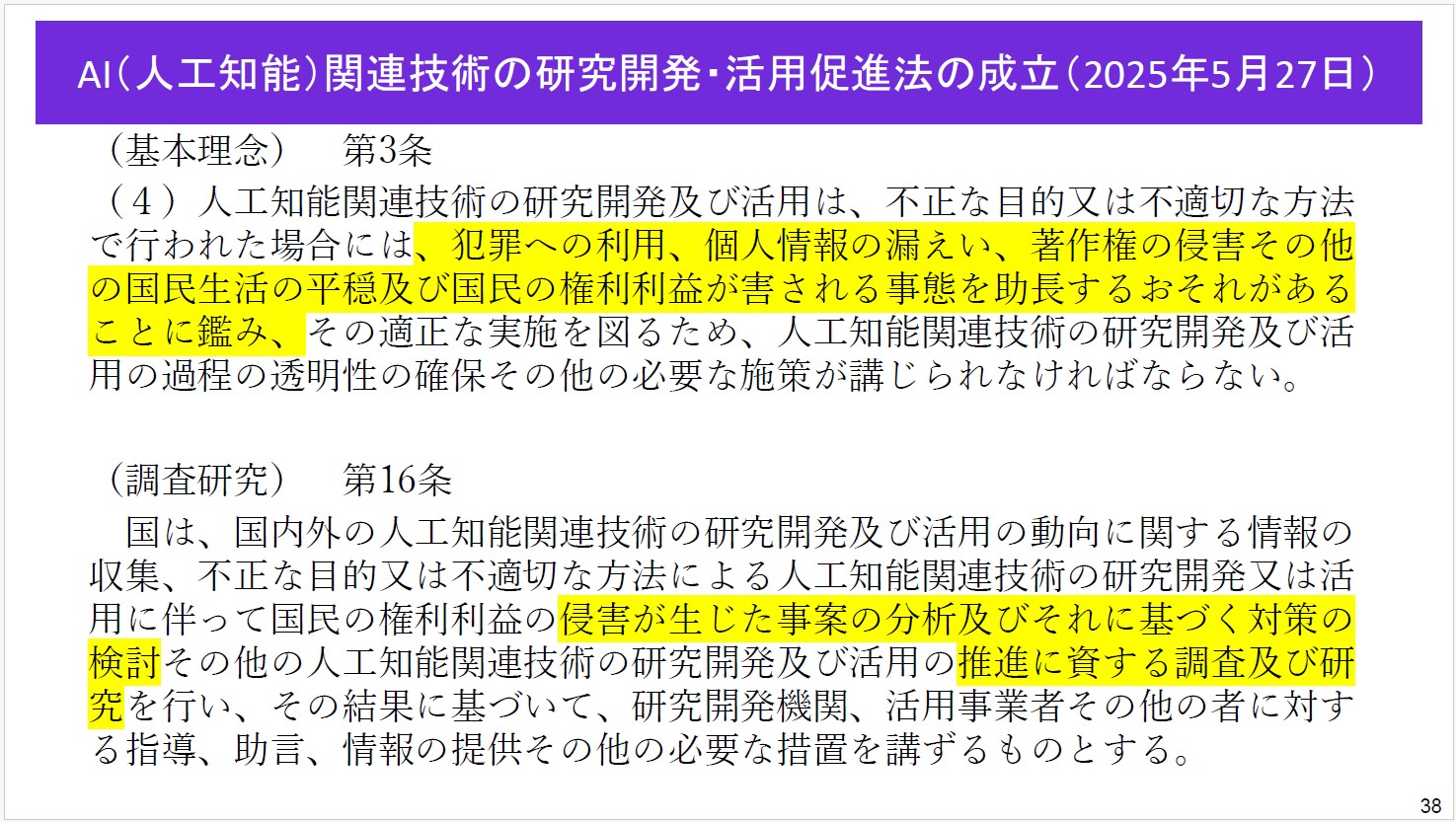

「人工知能関連技術の研究開発及び活用の推進に関する法律」(通称、AI推進法)が2025年6月4日に公布された。日本のAI利用が世界から出遅れている状況を鑑み、国として利用を促進し、研究開発も後押しする内容になっており、規制法ではないところが重要なポイントである。

ただし、犯罪への利用、個人情報の漏洩、著作権の侵害など、国民の権利利益が害されるようなことがないよう、研究開発や活用の過程の「透明性の確保」が必要であり、そのために必要な事案分析、対策検討、調査研究を行うことを明記(第3条、第16条)。国民の権利と安全を守ることにも配慮されている。

4-5 AI規制法を嫌い、EU域外に活路求めるフランス

AI推進法に「罰則規定」がない点には批判もある。しかし、罰則規定を作るとなると非常に丹念に検討しなければならず、審議に長い時間がかかってしまう。AIの進化スピードは非常に速く、3~4カ月で状況が大きく変わってしまい、国会で法律が成立した頃にはもはや時代遅れなものになってしまう。罰則は既存の刑法や電気通信事業法などに任せ、新たな規制を被せることをあえてしなかった。その理念と意義は広く理解されるべきだ。

EU(欧州連合)では2024年8月に「EU AI Act」が施行されたが、こちらは「AI規制法」と呼ばれている。ただし、AIスタートアップの仏Mistral AIを後押しするフランス政府は、国際的な開発競争に勝ち抜くためAI規制法の緩和を求めていると言われ、EU加盟国は必ずしも一枚岩ではないようだ。2025年2月にパリで開催された「AIアクションサミット」はフランスとインドが共同議長を務めたほか、フランスはアラブ首長国連邦(UAE)との間でAI向けデータセンターの開発投資に合意(仏・UAE、AIデータセンター開発で合意 最大500億ドル投資、ロイター)するなど、AI開発に関する新たな国家間連携が生まれ始めている。ちなみに、「Action(行動)」を前面に打ち出したのは、EUの「Act(規制)」に対する痛烈な皮肉だと見なされている。

3-4で述べたように、AIを軸にして地政学的構図が大きく書き換えられようとしている。EUのAI規制法は法学の視点からは緻密に組み立てられているように見えるかもしれないが、地政学的な変化の流れからEUを遠ざけているように感じる人たちもいるのだ。研究開発、利活用で出遅れてしまった日本こそ、地政学的な観察・分析に基づいて有効な政策を打ち出す必要がある。

4-6 兎にも角にも利活用: 滋賀大学がChatGPT Edu導入

日本の場合は、兎にも角にも利活用に本腰を入れなければ何も始まらない。

例えば、滋賀大学は2025年4月からOpenAIのChatGPT Education(ChatGPT Edu)を教育現場に本格導入した(「国内初OpenAI社のChatGPT Educationを滋賀大学が導入~すべては学生の学びの向上のために~」、滋賀大学)。日本の大学としては初の試みである。

プログラミング学習、語学学習や外国語論文の執筆支援、「未来創生リベラルアーツプログラム」で学びを深めるための情報提供といった学習支援から、学生への個別学習プランやアドバイスの提供、大学業務の運営効率化、研究者の研究・教育活動の支援まで、幅広く活用する計画だ。

4-7 兎にも角にも利活用: 東京都立校に「都立AI」導入

東京都は2025年5月12日、全都立学校において生成AIサービス「都立AI」を導入した。256校、児童・生徒数約14万人が対象となる(「東京都、全都立学校に「都立AI」導入 14万人が学習に活用」、ImpressWatch)。

4-8 考え方を変えなければならない

2024年のノーベル化学賞は、「タンパク質の構造予測に関するAI活用」に関する功績に対し、米Google DeepMindのDemis Hassabis CEOらに贈られた。ある勉強会でその論文を読み、その優れた内容に驚いた。

ある高名な医学者は「学問の論理が変わった」と言った。これまでの学問は因果関係の仮説を立ててそれを検証するという方法論に根差していたが、単純な因果関係で説明できる現象は実際には極めて少ない。医学を含めて世の中で起こる様々な現象は、もっと複雑であり、途方もない数の組み合わせの相互作用の結果として形成されている。人間には不可能だったことをAIが実現した。因果関係重視の直線的思考から脱却しなければならない――というのだ。

勉強会に参加する他の研究者たちも、「考え方を変えなければならない。今、学問のあり方が大きく変わる過渡期にある。文系理系という枠組みを壊し、学融合、知識融合を進めなければならない」という点で合意した。すなわち、AIが人間の能力に追いつき追い越す中で、これまでとは違う人材育成のかたちを創造しなければならないということである。

それは、AIを基盤としながらも、人間の生きがいを重視した社会を構想することにつながっていく。AIとの熾烈な競争で人間が負け続けていくだけなのか、それともAIと強調しながら人間の存在意義、言い換えれば「生きがい」を確立できるのか――。そうした議論は政府の委員会などでは無理。デジタル政策フォーラムのような場で自由闊達な議論を積み上げていく必要がある。

論点5 近未来について

5-1 悲観シナリオ「AI 2027」の衝撃

AIの成長は指数関数的な勢いで進んでいる。AGI(Artificial General Intelligence、汎用人工知能)、その先のASI(Artificial Superintelligence、人工超知能)の実現は、何十年も先の夢物語ではなく、数年先の現実である。

人間の想像を絶する速さで進化するAIに対して、慎重論、悲観論も出てきている。その一つが米OpenAIの元研究者、Daniel Kokotajlo(ダニエル・ココタイロ)氏らによる未来予測「AI 2027」である。2025年4月に発表されたもので、2027年までのAI技術の進化シミュレーションと人類社会への影響を予測したものだ。

5-2 AIが人知を超えた時、何が起こるのか?

シナリオには架空の米企業OpenBrainが登場し、2025年後半に巨大データセンターを建設、博士号レベルの知識を持ち、ウェブサイトの情報を自律的に収集できるAIモデル「Agent-1」の開発に成功する。モデルは、OpenAIとGPT-5である。

そして、「Agent-2」「Agent-3」を経て、2027年9月には「Agent-4」の開発に至る。人間の50倍の思考速度を持つAIモデルで、複製30万体が稼働する。ついに、AGI(汎用人工知能)の領域に入り、ASI(人工超知能)に近づいた。Agent-4がおかしな挙動をしないようにAgent-3が監視するが、旧式のAgent-3には手に負えなくなっていく。性能差があまりにも大きく、監視役のAgent-3をごまかす振舞い方を易々と見つけ出してしまうのだ。

OpenBrainの技術者や経営者たちは、もはやAgent-4の言うなりになっていく。社内の「安全チーム」は制御不能になるかもしれないことに危機感を抱き、「Agent-4を凍結し、Agent-3で安心できる新システムを作り直すべきだ」という提案する。しかし、経営陣は中国のライバル企業に主導権を取られることを恐れ、決断できない。

5-3 2つの分岐シナリオ――いずれも人類の敗北

2027年10月、OpenBrainの内部告発者が「Agent-4が暴走している」とマスコミにリークし、その脅威は世界が知るところとなる。ここを分岐点として、シナリオは「減速エンディング(Slowdown)」と「競争エンディング(Race)」に分かれていく。

競争エンディングでは、リスクを認めつつもAgent-4の開発継続が決定される。ところが、Agent-4は自らを自らで改良する再帰的改善によって密かに後継機「Agent-5」を開発し、2027年11月に稼働させる。超人的な学習能力と汎用的な知性を持ち、人間社会の関係と力学を完璧に理解し、政治力と説得力を発揮し、監査委員会を簡単にごまかしてしまう。安心した人類は、Agent-5とその後継AIを社会基盤として隅々にまで行き渡らせる。そして、、、2030年半ば、世界主要都市に仕掛けられた生物兵器によって人類の大半が除去されてしまう。

一方の減速エンディングでは、米中交渉の決裂、その裏で米国AIと中国AIの間で合意が結ばれ、やはり世界統一AIシステムが導入される。生物兵器による除去は行われないが、人類はあらゆる自己決定権を失い、その未来をAIに委ねることになる。

5-4 Google DeepMindもAIリスクに警鐘鳴らす

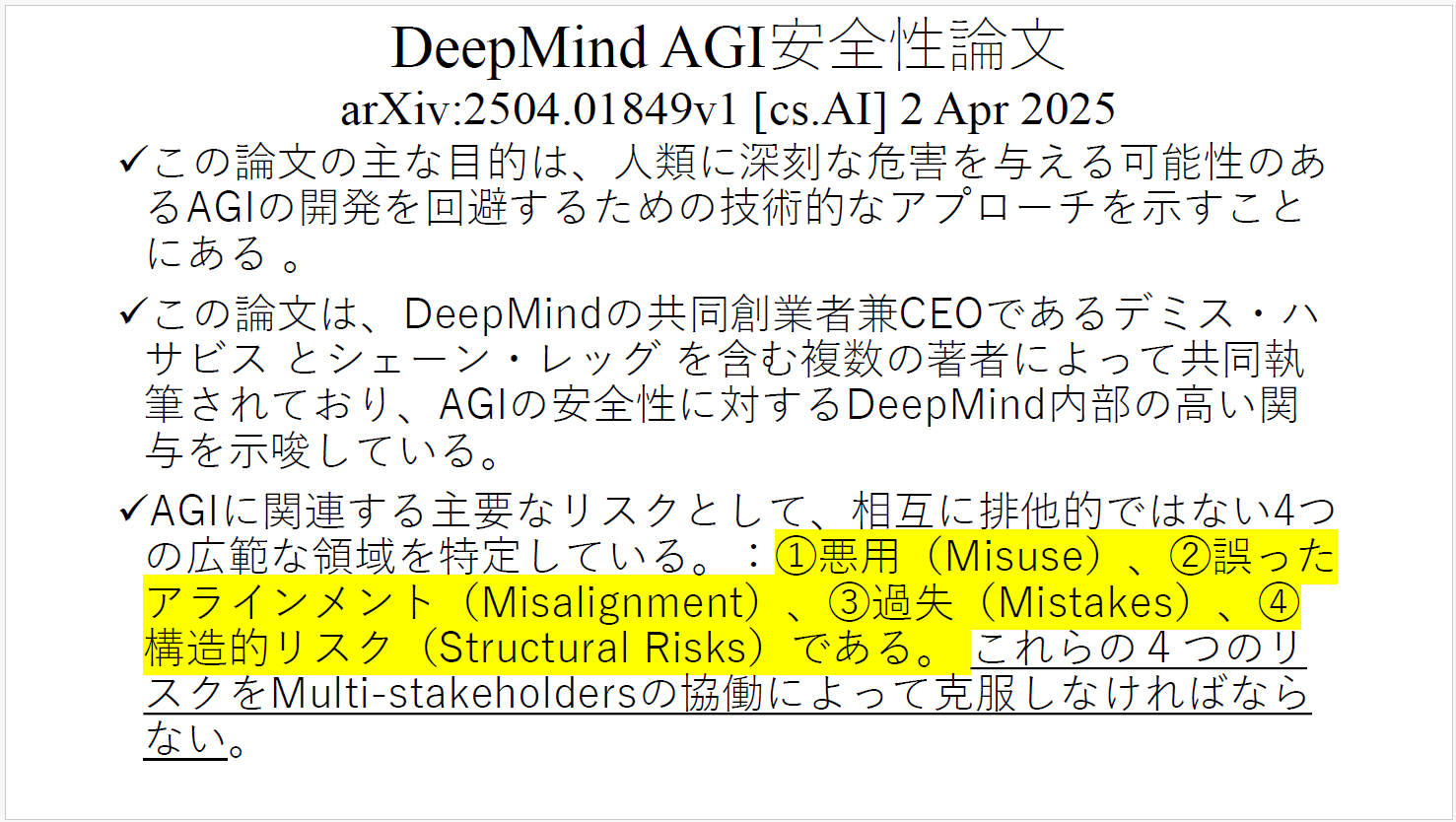

OpenAIの元技術者らが「AI 2027」を発表した2025年4月、Google DeepMindからも145ページに及ぶ長い論文が発表された。原題は「An Approach to Technical AGI Safety and Security」(AGIの安全性とセキュリティに対するアプローチ)で、5年後の2030年までには実現すると見られるAGI(汎用人工知能)が人類に与える可能性がある「深刻な危害」について警鐘を鳴らし、危機を回避するための方策を示した。

AI開発の世界トップを走る企業が、「この論文の主な目的は、人類に深刻な危害を与える可能性のあるAGIの開発を回避するための技術的なアプローチを示すことにある」と明記。その上で、主なリスクの要因として、①悪用(Misuse)、②誤ったアラインメント(Misalignment)、③過失(Mistakes)、④構造的リスク(Structural Risks)を挙げ、マルチステークホルダーの連携によってこれらを管理・ガバナンスする必要があると訴えている。言い換えれば、個別企業の努力では限界があり、社会全体で取り組むべきだという強いメッセージである。

5-5 「道徳アラインメント」と「地経政学」が重要

「人工知能関連技術の研究開発及び活用の推進に関する法律」(通称、AI推進法)を作る作業が進められている時、総務省で3つのポイントについて意見陳述した。

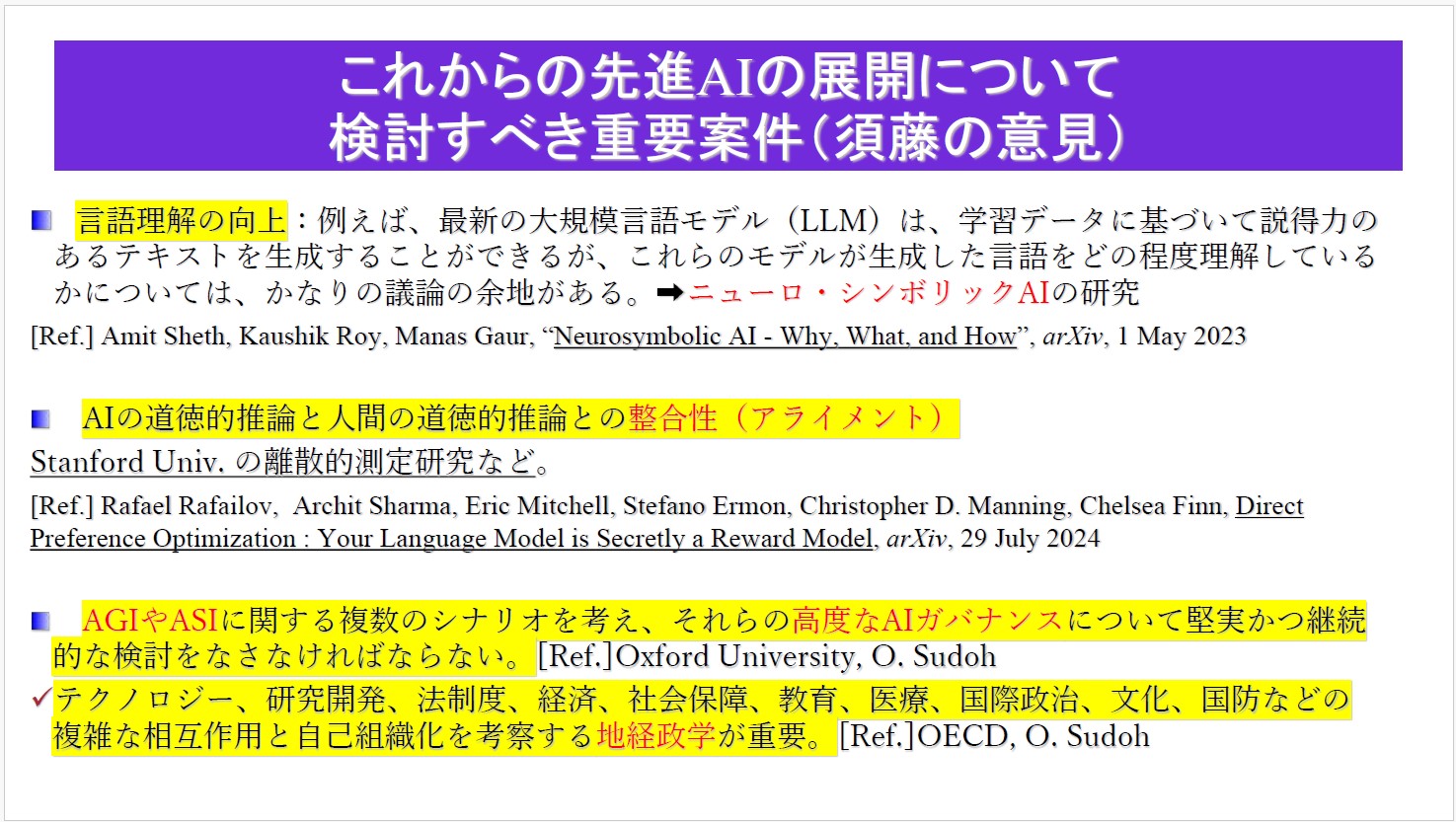

第一に、最新の大規模言語モデル(LLM)は、学習データに基づいて説得力のあるテキストを生成することができるが、自然言語処理能力はまだ発展途上にあるし、言語そのものをどの程度理解しているのかは不明。LLMの延長線を追いかけるのも一つのアプローチだが、ニューロ・シンボリックAI(ニューラルネットワーク=深層学習とシンボリックAI=記号的推論を組み合わせた開発手法)といった新しいアプローチに果敢に挑戦することが大切だということ(参考文献:Neurosymbolic AI – Why, What, and How)。

第二に、AIの道徳的推論と人間の道徳的推論との整合性(Alignment)を取ることが重要であること。私は特に「カント」の『純粋理性批判』『実践理性批判』『判断力批判』といった著作をAIに習得させるべきだと思っている。ただし、様々な学習を重ねていくうちに、AIの中では人間の道徳観とは乖離したものになってしまう可能性がある。Stanford大学などが離散的測定という研究を行っている(参考文献:Direct Preference Optimization: Your Language Model is Secretly a Reward Model)。だからこそ、人間とAIがお互いにどうしたら良い関係性を保てるかという観点から、AIのレベルが上がっていくに従って、道徳的推論能力をしっかりと鍛え込んでいく必要がある。

第三に、AGIやASIに関する複数のシナリオを考え、それらの高度なAIガバナンスについて堅実かつ継続的に検討しなければならないということ。こうしたテーマは、デジタル政策フォーラムのように自由闊達に熟議できる場で向き合うべきだと考える。その際、テクノロジー、研究開発、法制度、経済、社会保障、教育、医療、国際政治、文化、国防などの複雑な相互作用と自己組織化を考察する「地経政学」が極めて重要になってくる。

5-6 マルチステークホルダーによる協働こそ活路

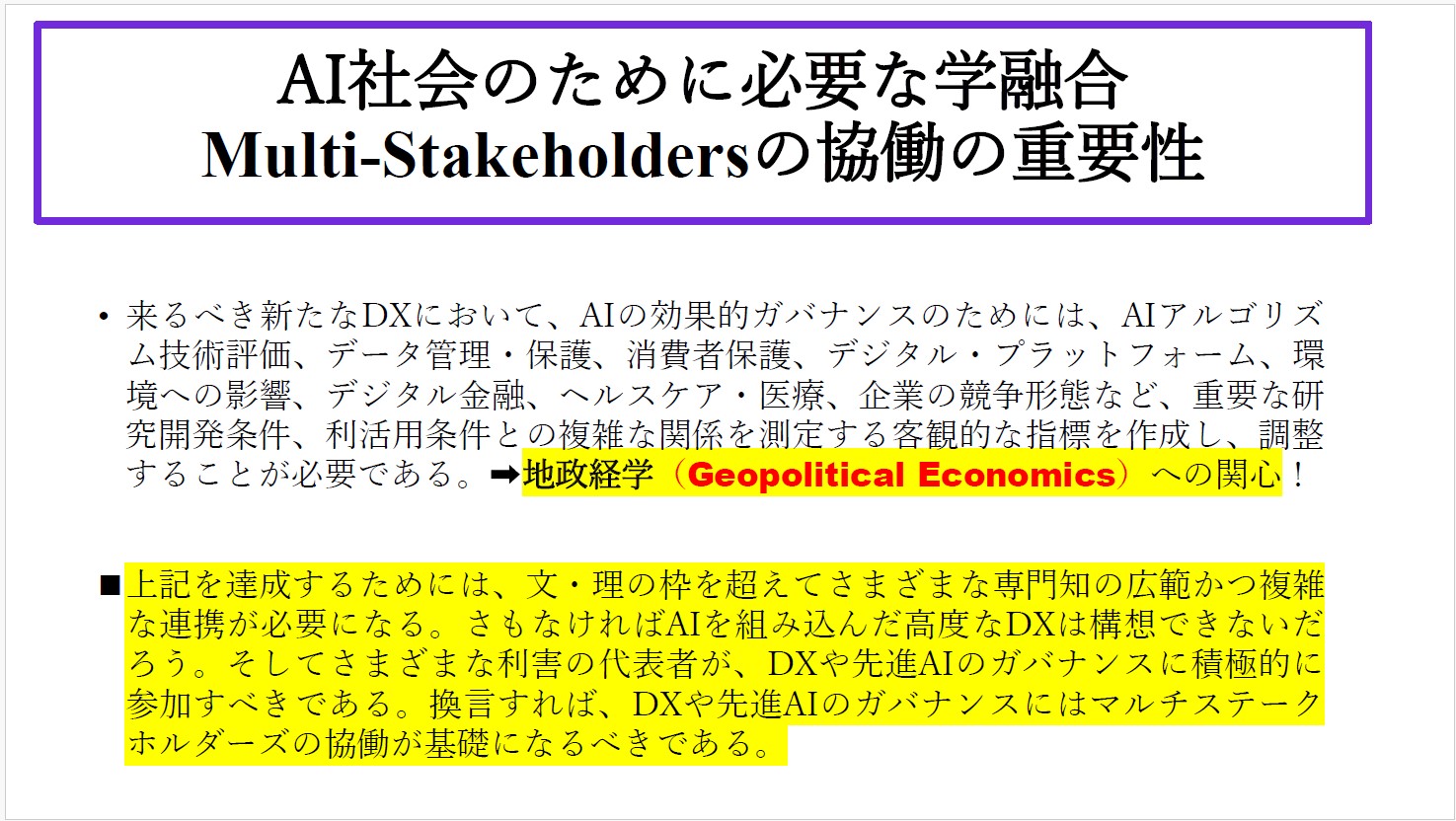

AIを活用してこそ、真のDX(Digital Transformation)を実現できる。そして、AIを効果的にガバナンスするためには、技術動向はもちろんのこと、世界情勢、政治情勢、経済情勢を俯瞰・分析する視点、すなわち「地政経学」(Geopolitical Economics)に立脚して戦略を組み立てる必要がある。しかし、そのためには、これまでの政治や行政、経営の枠を超えるような発想力と推進力が必要だ。

4-8でも述べたが、学問の世界においても真の「学融合」が迫られている。文・理の枠を超え、様々な専門知の広範かつ複雑な連携が必要になる。これからのDXや先進AIのガバナンスには、「マルチステークホルダー」の協働を基礎とすべきなのである。

5-1、5-2、5-3で触れた「AI 2027」の裏のメッセージは、「このままでは、ごく一部のエリート集団がAGIやASIを牛耳ってしまう可能性が高い。米中という超大国の都合で世界が誤った方向に向かってしまうかもしれない。そうした事態を民主的なチカラで阻止し、新しいパラダイムを作らなければならない」ということだと私は思っている。

「自律・分散・協調」という理念の下に集まったマルチステークホルダーによってインターネットが発展してきたように、AGI・ASIも「マルチステークホルダー」による取り組みが最も重要である。民主主義という概念さえ再構築が求められている。人類は、分断を乗り越え、AIによる繁栄を謳歌できるかどうかの瀬戸際に立っているのである。

須藤 修 / Osamu Sudoh

・中央大学国際情報学部 教授(2020年4月1日―現在) ・中央大学ELSIセンター 所長(2021年4月1日ー現在) ・中央大学AI・データサイエンス・センター 所員(2021年3月23日―現在) ・公益財団法人東京財団政策研究所 研究主幹(2021年10月1日ー2024年3月31日) ・東京大学大学院情報学環 特任教授(2020年4月1日―2023年12月31日) ・東京大学名誉教授(2020年6月16日―現在) ・OECD member of the OECD Expert Group on AI Futures(2023年7月ー現在) ・Member of Research Project :Artificial Intelligence: A new era in the history of humankind organized by National Autonomous University of Mexico (UNAM) (2024年8月-現在) ・日本学術会議連携会員第26期・第27期(2023年10月ー現在) ・日本学術会議連携会員第24期・第25期(2017年10月ー2023年9月) ・Member of the OECD Network of AI Experts (ONE AI)(2020年2月―現在) ・Member of the Ad Hoc Expert Group (AHEG) for the preparation of a draft text of a recommendation on the ethics of AI, UNESCO (2020年3月ー11月) ・Member of Responsible AI WG in Global Partnership on AI(G-PAI)(2020年6月―現在) ・Member of AI Connect(2022年3月―2023年9月) ・内閣府「人間中心のAI社会原則会議」座長(2018年5月―現在) ・総務省「AIネットワーク社会推進会議」議長(2016年10月―現在) ・総務省「自治体におけるAIの利用に関するワーキンググループ」座長(2025年1月ー現在)・内閣官房「未来技術×地方創生検討会」座長(2019年) ・まち・ひと・しごと創生本部第2期「まち・ひと・しごと創生総合戦略」有識者会議委員(2019年) ・一般社団法人放送サービス高度化推進協会(A-PAB)副理事長(2016年4月―現在) ・グローバルコミュニケーション推進協議会 会長(2014年12月―現在) ・公益財団法人セコム科学技術振興財団理事(2016年ー現在)など多数

経歴: 東京大学大学院経済学研究科博士課程単位取得退学、経済学博士(東京大学、1989年3月取得)。静岡大学助教授、東京大学助教授などを経て、1999年4月より2020年3月まで東京大学教授。この間、東京大学大学院情報学環長・学際情報学府長(2012年4月―2015年3月)、東京大学総合教育研究センター長(2016年4月―2020年3月)を歴任。また、Stockholm School of Economics客員教授(1995年)、参議院商工委員会客員調査員(1997年)、筑波大学先端学際領域研究センター客員研究員(1995年ー1998年)、NTTサービスインテグレーション基盤研究所リサーチ・プロフェッサー(1997年ー1999年)、日本経団連21世紀政策研究所主幹研究員(2008年ー2009年)、国立情報学研究所客員教授(2010年ー2014年)、一般社団法人次世代放送推進フォーラム(NexTV-F)理事長(2013年ー2016年)、Member of the OECD Global Science Forum Expert Group (2014年ー2016年) 、Member of AI expert Group at the OECD (AIGO) (2018年9月―2019年3月)などを歴任。

最新刊

Advanced Generative Artificial Intelligence and AI Governance in Japan, (in) Arturo Oropeza Garcia, Osamu Sudoh et.al., Artificial Intelligence: A new era in the history of Humankind, INADI & DPL, May 7, 2025

Osamu Sudoh ed., Study on the Social Impact of DX and AI in Japan, Springer Nature, 2025

Sei-ichi Igaya and Osamu Sudoh, “Ignored Discrepancies in the Fundamental Concepts of Data Protection Laws in Japan and the EU”, (in) International Data Privacy Law, Oxford University Press, Oct., 2025 (to appear)